۷ دیدگاه

۲۳ مرداد ۱۴۰۲، ۰۸:۲۱

نازنین کریمی مقدم

۱۹ شهریور ۱۴۰۲، ۱۰:۱۴

۱۳ تیر ۱۴۰۱، ۰۸:۱۸

۲۴ بهمن ۱۴۰۰، ۰۸:۴۸

۲۸ دی ۱۴۰۰، ۱۹:۰۷

مهتاب

۲۷ دی ۱۳۹۹، ۲۰:۵۶

لیلا افشار

۱۸ آذر ۱۳۹۹، ۰۰:۲۴

دوره الفبای برنامه نویسی با هدف انتخاب زبان برنامه نویسی مناسب برای شما و پاسخگویی به سوالات متداول در شروع یادگیری موقتا رایگان شد:

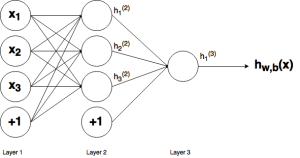

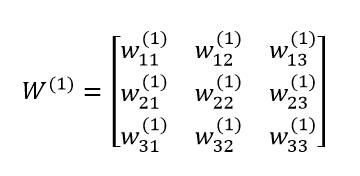

این ماتریس را میتوان با استفاده از آرایههای numpy به راحتی نمایش داد:

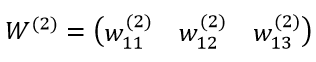

این ماتریس را میتوان با استفاده از آرایههای numpy به راحتی نمایش داد: کد پایتون زیر نحوه ی تعریف آرایه ی وزنی لایه ی 2 را نشان میدهد:

کد پایتون زیر نحوه ی تعریف آرایه ی وزنی لایه ی 2 را نشان میدهد:

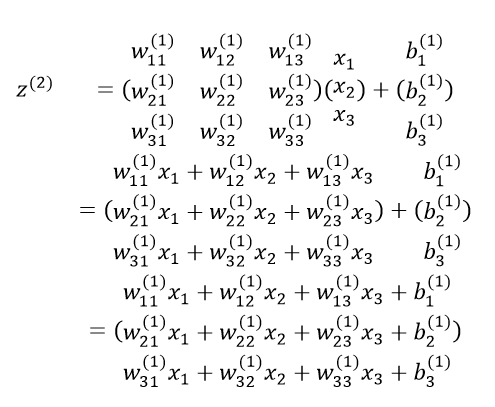

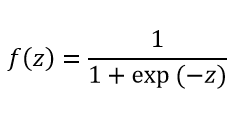

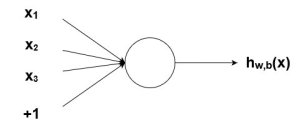

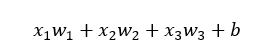

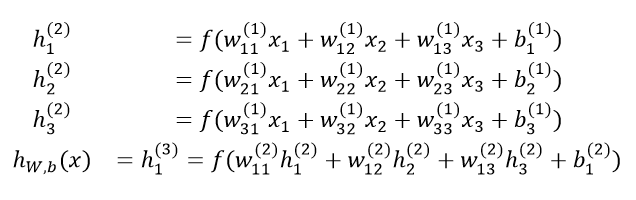

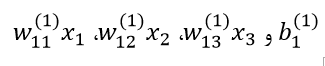

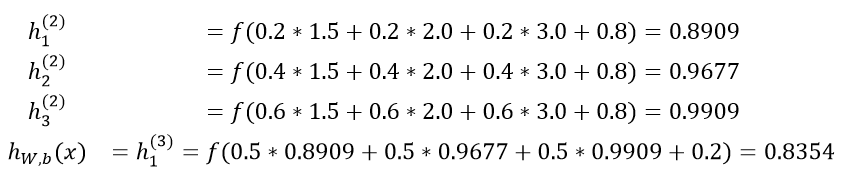

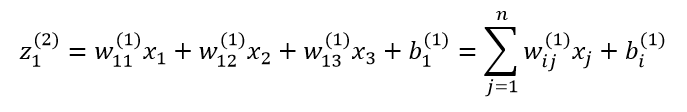

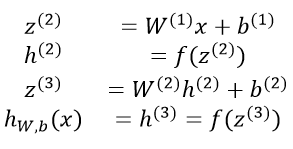

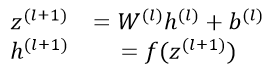

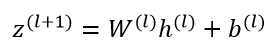

توجه کنید که در این معادله h(l)=x است. گسترش معادله ی بالا برای لایه ی ورودی به شکل زیر است:

توجه کنید که در این معادله h(l)=x است. گسترش معادله ی بالا برای لایه ی ورودی به شکل زیر است: