- Crawl Budget چیه؟

- خزنده چطور کار میکنه؟

- چه زمانی باید نگران Crawl Budget باشیم؟

- گوگل کدوم URLها رو خزش میکنه؟

- چطور فعالیت خزش رو بررسی کنیم

- چرا Crawl Budget برای سئو مهمه؟

- گوگل چطور خزش خودش رو تنظیم میکنه؟

- چطور گوگل رو وادار کنیم سریعتر خزش کنه

- چطور گوگل رو وادار کنیم کندتر خزش کنه

- 7 نکته برای بهینهسازی Crawl Budget

- سوالات متداول

- جمعبندی

گوگل همیشه همه صفحات یه سایت رو به سرعت نمیخزه. بعضی وقتها ممکنه هفتهها طول بکشه. این موضوع میتونه مانع از تلاشهای سئو تو بشه. مثلاً صفحه جدید و بهینهشدهای که ساختی ممکنه به موقع ایندکس نشه. اینجاست که باید به فکر بهینهسازی crawl budget بیفتی. توی این مقاله، میخوایم درباره اینکه crawl budget چیه و چطور میتونی اون رو بهینه کنی صحبت کنیم.

Crawl Budget چیه؟

Crawl budget یا بودجهی خزیدن، تعداد صفحاتی هست که گوگل هر روز روی سایتت خزش میکنه. این عدد ممکنه هر روز کمی تغییر کنه، اما به طور کلی ثابت میمونه. ممکنه گوگل هر روز ۶ صفحه از سایتت رو خزش کنه، شاید هم ۵۰۰۰ صفحه یا حتی ۴۰۰۰۰۰۰ صفحه رو هر روز بررسی کنه. تعداد صفحاتی که گوگل خزش میکنه، یعنی همون بودجهی تو، معمولاً بستگی به اندازهی سایت، سلامت سایت (تعداد ارورهایی که گوگل با اونها مواجه میشه) و تعداد لینکهای ورودی به سایتت داره. بعضی از این عوامل چیزهایی هستن که تو میتونی روشون تاثیر بذاری؛ پس نگران نباش، به زودی دربارهشون صحبت میکنیم.

خزنده چطور کار میکنه؟

خوب، بزار ببینیم این خزندهها مثل گوگلبات چطور کار میکنن. اول از همه، یه لیست از URLهای سایت تو دارن که باید خزش کنن. گوگلبات میاد و به ترتیب این لیست رو بررسی میکنه. هر از گاهی هم فایل robots.txt سایتت رو چک میکنه تا مطمئن بشه هنوز اجازه داره به URLها دسترسی داشته باشه و بعدش هر URL رو جداگانه خزش میکنه.

وقتی گوگلبات یه URL رو خزش کرد و محتوای اون رو بررسی کرد، URLهای جدیدی که توی اون صفحه پیدا میکنه رو به لیست کارهایی که باید انجام بده اضافه میکنه. چندین اتفاق میتونه باعث بشه گوگل بخواد یه URL رو خزش کنه؛ مثلاً شاید لینکهای جدیدی به اون محتوا اشاره کرده باشن، یا کسی توییترش کرده باشه، یا اینکه توی نقشه سایت XML آپدیت شده باشه و... دلایلش خیلی زیاده و نمیشه همه رو لیست کرد. اما وقتی گوگل تصمیم بگیره که یه URL رو خزش کنه، اون رو به لیست کارهای خودش اضافه میکنه.

اگه نمیدونی Web Crawler یا خزنده وب چیه، پیشنهاد میکنم اول یه سر به مقاله "Web Crawler چیست؟" بزنی😉

چه زمانی باید نگران Crawl Budget باشیم؟

Crawl budget معمولاً برای صفحاتی که محبوبیت زیادی دارن مسئلهای نیست. مشکل بیشتر برای صفحات جدیدتر، صفحاتی که لینکهای کمی دارن یا تغییرات کمی دارن پیش میاد.

چرا Crawl Budget اهمیت داره؟

اگر سایتت جدیده و تعداد صفحات زیادی داره، ممکنه مسئلهای به نام crawl budget داشته باشی. سرور تو ممکنه بتونه خزش بیشتری رو پشتیبانی کنه، اما چون سایتت تازه است و هنوز محبوبیت زیادی نداره، موتور جستجو ممکنه نخواهد خیلی به صفحاتت سر بزنه. این یه عدم تطابق انتظاراته. تو میخوای صفحاتت خزش و ایندکس بشن، اما گوگل نمیدونه آیا ارزشش رو داره یا نه و شاید نخواد به اندازهای که تو میخوای، صفحاتت رو خزش کنه.

کی Crawl Budget مشکل ساز میشه؟

Crawl budget وقتی مشکل میشه که تعداد زیادی URL توی سایتت داشته باشی و گوگل نتونه به اندازه کافی خزش کنه. فرض کن سایتت ۲۵۰۰۰۰ صفحه داره و گوگل هر روز ۲۵۰۰ صفحه از سایتت رو خزش میکنه. بعضی صفحات مثل صفحه اصلی رو بیشتر از بقیه خزش میکنه. اینجوری ممکنه تا ۲۰۰ روز طول بکشه تا گوگل تغییرات توی صفحاتت رو متوجه بشه. اینجاست که باید نگران crawl budget بشی. اما اگر هر روز ۵۰۰۰۰ صفحه رو خزش کنه، دیگه مشکلی نداری.

چطور بفهمیم سایت ما مشکل Crawl Budget داره؟

برای اینکه بفهمی سایتت مشکل crawl budget داره یا نه، این مراحل رو دنبال کن:

- تعداد صفحات سایتت رو تعیین کن؛ تعداد URLها توی نقشه سایت XML میتونه نقطه شروع خوبی باشه.

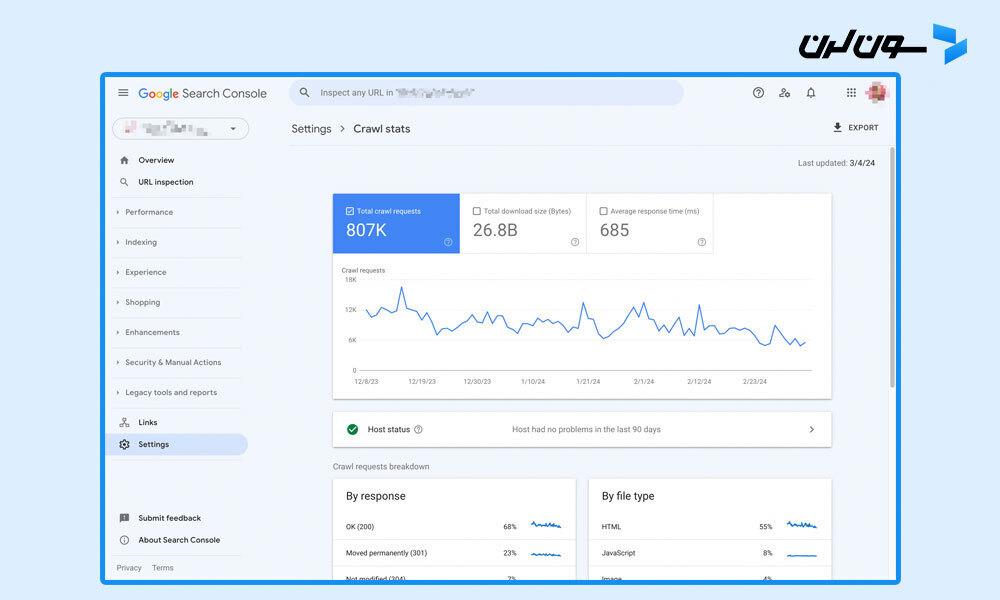

- به گوگل سرچ کنسول برو.

- به "Settings" -> "Crawl stats" برو و تعداد میانگین صفحات خزش شده در روز رو حساب کن.

- تعداد صفحات رو بر "میانگین صفحات خزش شده در روز" تقسیم کن.

اگر عددی که به دست میاری بیشتر از ۱۰ باشه (یعنی ۱۰ برابر بیشتر از تعداد صفحاتی که گوگل روزانه خزش میکنه)، احتمالاً باید بودجه خزیدنت رو بهینهسازی کنی. اما اگر عدد کمتر از ۳ باشه، نیازی به نگرانی نیست.

گوگل کدوم URLها رو خزش میکنه؟

خیلی مهمه که بدونی گوگل کدوم URLهای سایتت رو خزش میکنه. بهترین راه برای این کار، بررسی لاگهای سرور سایتته. برای سایتهای بزرگ، میتونی از ابزارهایی مثل Logstash و Kibana استفاده کنی. برای سایتهای کوچیکتر، ابزار SEO Log File Analyser از Screaming Frog خیلی کمککننده است.

بسته به نوع هاستینگت، ممکنه همیشه نتونی به لاگ فایلها دسترسی داشته باشی. ولی اگه سایتت بزرگه و میخوای بودجه خزیدن رو بهینه کنی، باید به لاگها دسترسی داشته باشی. اگه هاستت اجازه نمیده، وقتشه که هاستینگ رو عوض کنی.

چطور فعالیت خزش رو بررسی کنیم

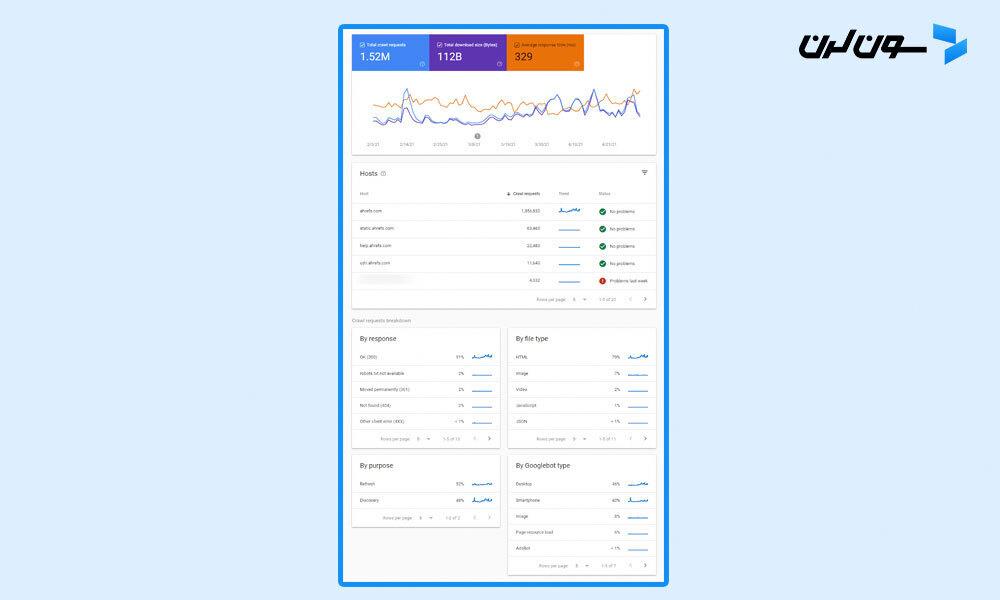

اگه میخوای یه نمای کلی از فعالیت خزش گوگل و مشکلاتی که شناسایی کرده ببینی، بهترین جایی که میتونی سر بزنی گزارشهای Crawl Stats توی Google Search Console هست.

این گزارشها بهت کمک میکنن تغییرات در رفتار خزش، مشکلات خزش و اطلاعات بیشتری درباره چگونگی خزش گوگل روی سایتت رو شناسایی کنی.

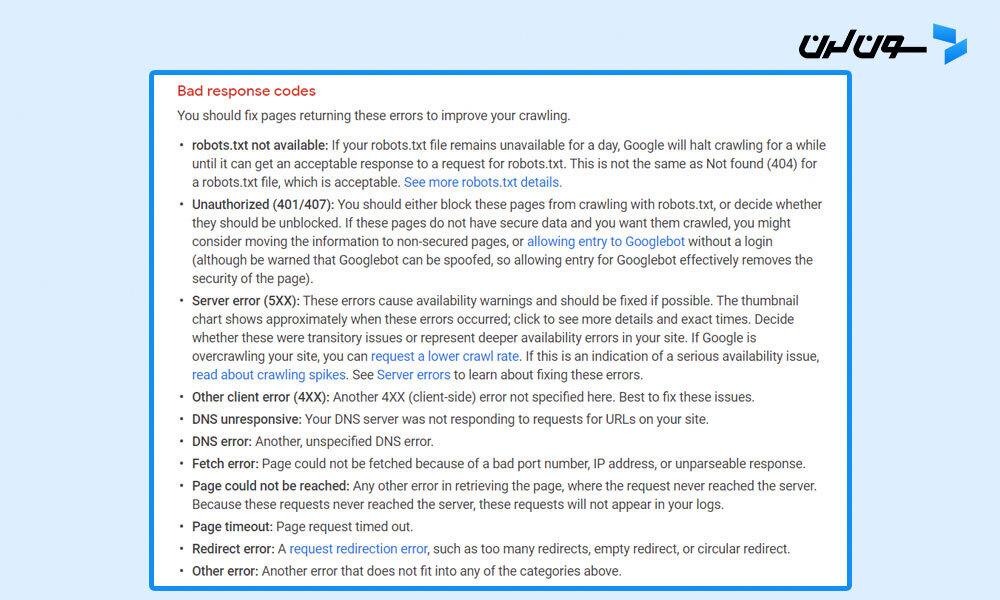

حتماً باید به وضعیتهای خزش که علامتگذاری شدن دقت کنی، مثل نمونههای زیر:

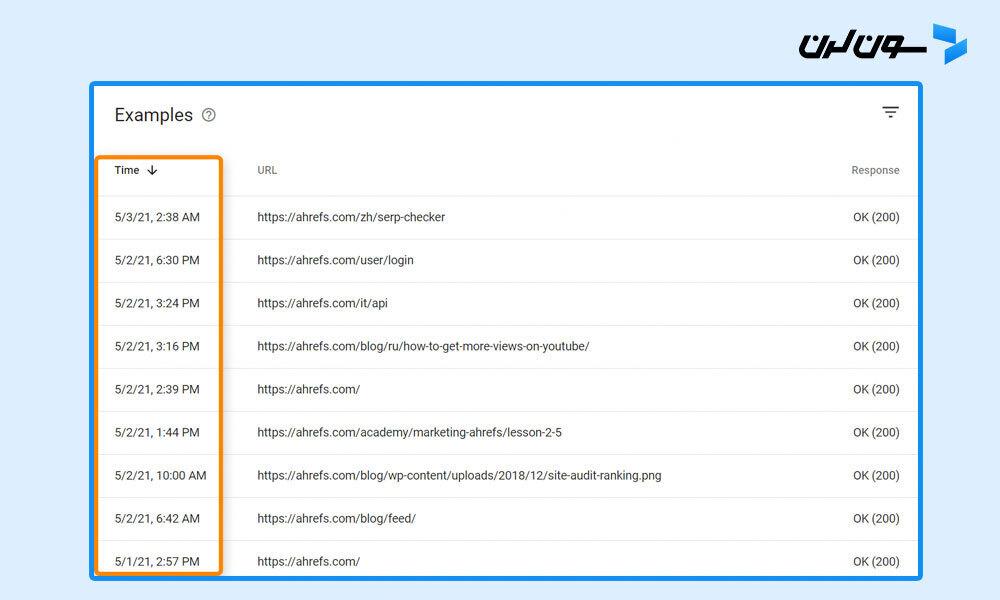

همچنین میتونی زمانبندیهایی رو ببینی که صفحات آخرین بار خزش شدن.

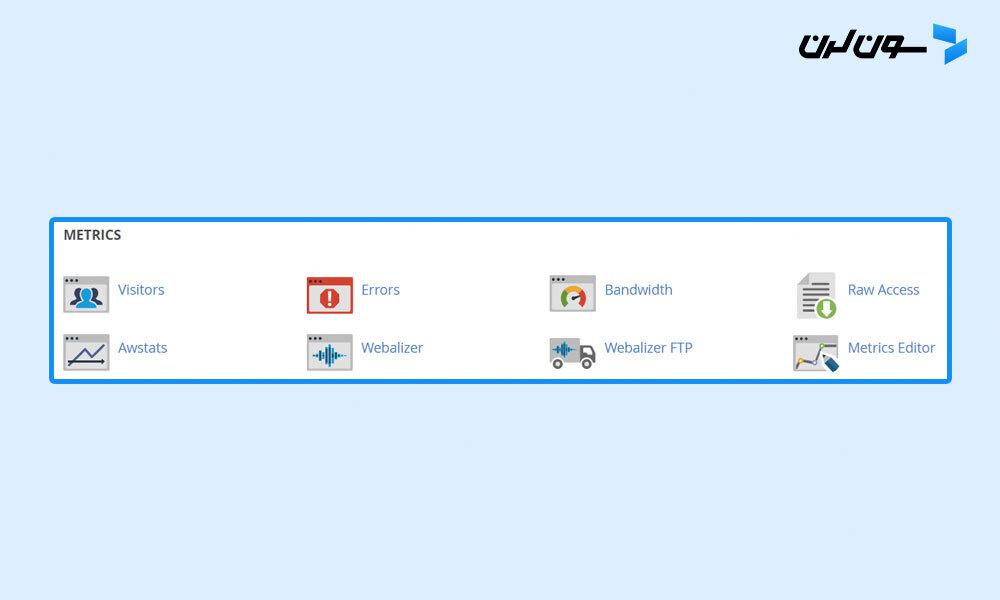

اگه میخوای تمامی بازدیدها از رباتها و کاربران رو ببینی، باید به لاگ فایلها دسترسی داشته باشی. بسته به هاستینگ و تنظیمات سایتت، ممکنه به ابزارهایی مثل Awstats و Webalizer دسترسی داشته باشی که این ابزارها برخی از دادههای تجمیعشده لاگ فایلها رو نمایش میدن.

برای تنظیمات پیچیدهتر، باید به لاگ فایلهای خام دسترسی داشته باشی و دادهها رو از چندین منبع ذخیره کنی. همچنین ممکنه به ابزارهای خاصی برای پروژههای بزرگتر نیاز داشته باشی، مثل مجموعه ELK (Elasticsearch, Logstash, Kibana) که اجازه ذخیره، پردازش و تصویریسازی لاگ فایلها رو میده. ابزارهای تحلیل لاگ مثل Splunk هم میتونن مفید باشن.

چرا Crawl Budget برای سئو مهمه؟

برای اینکه صفحاتت توی نتایج جستجوی گوگل دیده بشن، اول باید گوگل اونا رو خزش و بعد ایندکس کنه. این دو مرحله باید بدون مشکل انجام بشن تا محتوای سایتت توی نتایج جستجو نمایش داده بشه.

این موضوع میتونه به طور قابل توجهی روی ترافیک ارگانیک سایتت تاثیر بذاره و اهداف کلی کسبوکارت رو تحت تاثیر قرار بده.

بیشتر صاحبان سایتها نباید خیلی نگران crawl budget باشن، چون گوگل به خوبی سایتها رو خزش میکنه. اما توی چند موقعیت خاص، بودجه خزش گوگل برای سئو خیلی مهم میشه:

- سایت خیلی بزرگه: اگه سایتت بزرگ و پیچیده است (بیش از ۱۰ هزار صفحه داره)، ممکنه گوگل نتونه به سرعت صفحات جدید رو پیدا کنه یا همه صفحاتت رو مرتباً خزش کنه.

- صفحات جدید زیادی اضافه میکنی: اگه به طور مکرر صفحات جدید اضافه میکنی، بودجه خزش میتونه روی دیده شدن اون صفحات تاثیر بذاره.

- سایتت مشکلات فنی داره: اگه مشکلاتی توی خزش سایتت وجود داشته باشه، ممکنه محتوای سایتت توی نتایج جستجو نمایش داده نشه.

گوگل چطور خزش خودش رو تنظیم میکنه؟

هر سایت یه بودجه خزش متفاوت داره که از چندین عامل مختلف تشکیل شده.

تقاضای خزش (Crawl Demand)

تقاضای خزش یعنی چقدر گوگل میخواد صفحات سایتت رو خزش کنه. صفحات محبوبتر و صفحاتی که تغییرات زیادی دارن، بیشتر خزش میشن.

صفحات محبوب، یا اونهایی که لینکهای بیشتری دارن و PageRank بالاتری دارن، معمولاً نسبت به بقیه صفحات اولویت دارن. یادت باشه که گوگل باید به نوعی صفحات سایتت رو برای خزش اولویتبندی کنه و لینکها راه سادهای هستن که بفهمه کدوم صفحات محبوبترن. این مسئله فقط برای سایت تو نیست، بلکه برای همه صفحات همه سایتهای اینترنت هست که گوگل باید براشون اولویت تعیین کنه.

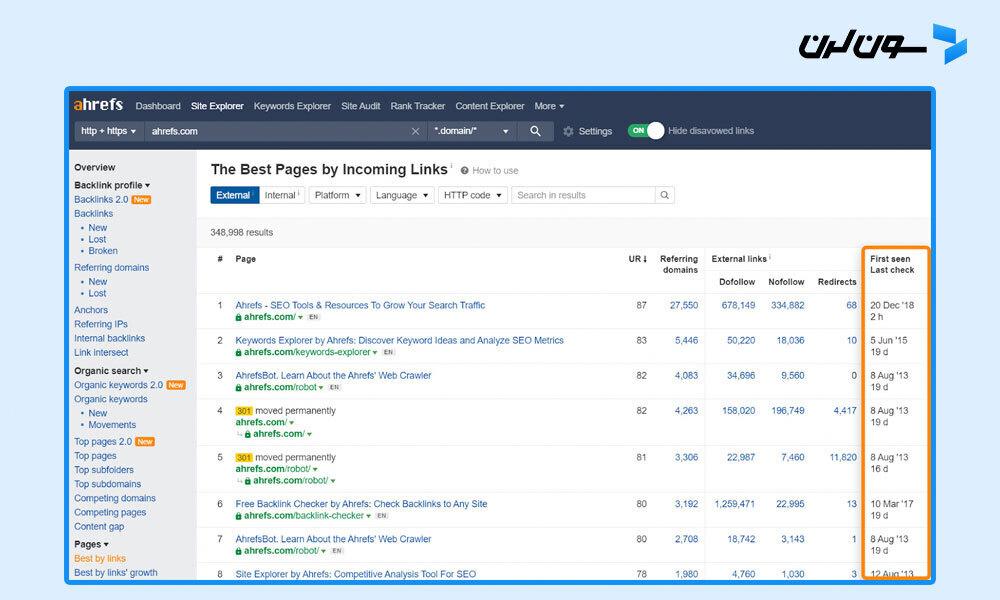

میتونی از گزارش "Best by links" در Site Explorer به عنوان نشونهای استفاده کنی که کدوم صفحاتت احتمالاً بیشتر خزش میشن. این گزارش همچنین نشون میده آخرین باری که Ahrefs صفحاتت رو خزش کرده کی بوده.

گوگل همچنین بررسی میکنه که کدوم صفحات رو بیشتر توی ایندکسش نشون میده تا تقاضای خزش رو تعیین کنه. اونا میخوان صفحات پرکاربرد رو بیشتر خزش کنن تا مطمئن شن بهروز هستن.

یه مفهوم دیگه هم به اسم "staleness" وجود داره. اگر گوگل ببینه که یه صفحه تغییر نمیکنه، کمتر اون رو خزش میکنه. مثلاً، اگه یه صفحه رو خزش کنه و بعد از یه روز ببینه هیچ تغییری نکرده، ممکنه سه روز صبر کنه تا دوباره خزش کنه، بعد ده روز، بعد ۳۰ روز، بعد ۱۰۰ روز و... . هیچ دوره زمانی مشخصی وجود نداره که بین دو خزش صبر کنه، ولی با گذشت زمان کمتر خزش میکنه. اما، اگر گوگل تغییرات بزرگی روی کل سایت یا جابهجایی سایت ببینه، معمولاً نرخ خزش رو حداقل به طور موقت افزایش میده.

محدودیت نرخ خزش (Crawl Rate Limit)

محدودیت نرخ خزش یعنی سایتت چقدر خزش میتونه پشتیبانی کنه. سایتها یه میزان مشخصی خزش رو میتونن تحمل کنن قبل از اینکه مشکلاتی مثل کندی یا خطاهای سرور پیش بیاد. بیشتر خزندهها وقتی این مشکلات رو ببینن، خزش رو کم میکنن تا به سایت آسیبی نرسه.

گوگل بر اساس سلامت خزش سایت، تنظیماتش رو انجام میده. اگه سایتت با خزش بیشتر مشکلی نداشته باشه، محدودیت خزش افزایش پیدا میکنه. اما اگه سایتت مشکل داشته باشه، گوگل نرخ خزش رو کاهش میده.

اگه گوگل تعداد زیادی کد وضعیت 5xx (خطاهای سرور) یا 429 (درخواستهای زیاد) دریافت کنه، خزش رو کم میکنه. همچنین اگه زمانهای اتصال سرور طولانی بشه، گوگل خزش خودش رو کاهش میده.

چطور گوگل رو وادار کنیم سریعتر خزش کنه

اگه میخوای گوگل سریعتر سایتت رو خزش کنه، چند تا کار هست که میتونی انجام بدی تا سایتت از پس خزش بیشتر بربیاد و تقاضای خزش رو افزایش بدی. بیایید نگاهی به این گزینهها بندازیم.

سرعت سرورت رو بالا ببر / منابع رو افزایش بده

گوگل وقتی صفحات رو خزش میکنه، منابع رو دانلود و بعدش پردازش میکنه. سرعت صفحه از دید کاربر هم مهمه ولی چیزی که روی بودجه خزش تاثیر میذاره، سرعت اتصال و دانلود منابع توسط گوگله. لاگهات رو برای هر گونه خطای 5xx یا 429 بررسی کن.

لینکهای بیشتر، خارجی و داخلی

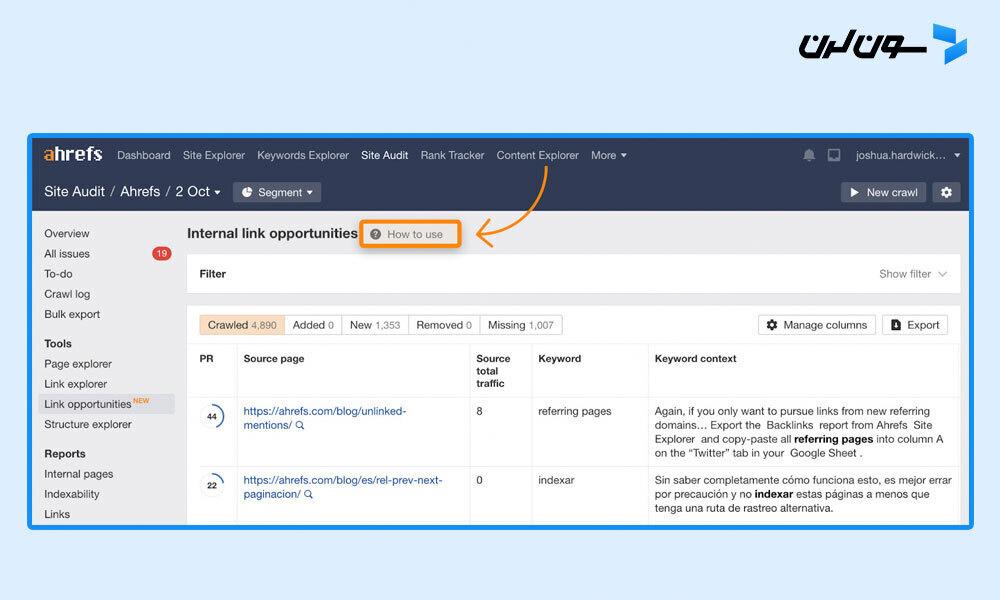

یادت باشه که تقاضای خزش عموماً براساس محبوبیت یا لینکهاست. میتونی بودجه خزش رو با افزایش تعداد لینکهای خارجی و/یا داخلی بیشتر کنی. لینکهای داخلی راحتترن چون کنترلشون دست خودته. میتونی لینکهای داخلی پیشنهادی رو توی گزارش "Link Opportunities" در Site Audit پیدا کنی که یه آموزش هم داره که چطوری این کار رو انجام بدی.

رفع لینکهای ریدایرکت شده

نگهداشتن لینکهای ریدایرکت شده توی سایت میتونه کمی روی بودجه خزش تاثیر بذاره. معمولاً این صفحات اولویت پایینی دارن چون احتمالاً تغییر خاصی نکردن، ولی پاک کردن این مشکلات برای نگهداری کلی سایت خوبه و به بودجه خزش هم کمک میکنه.

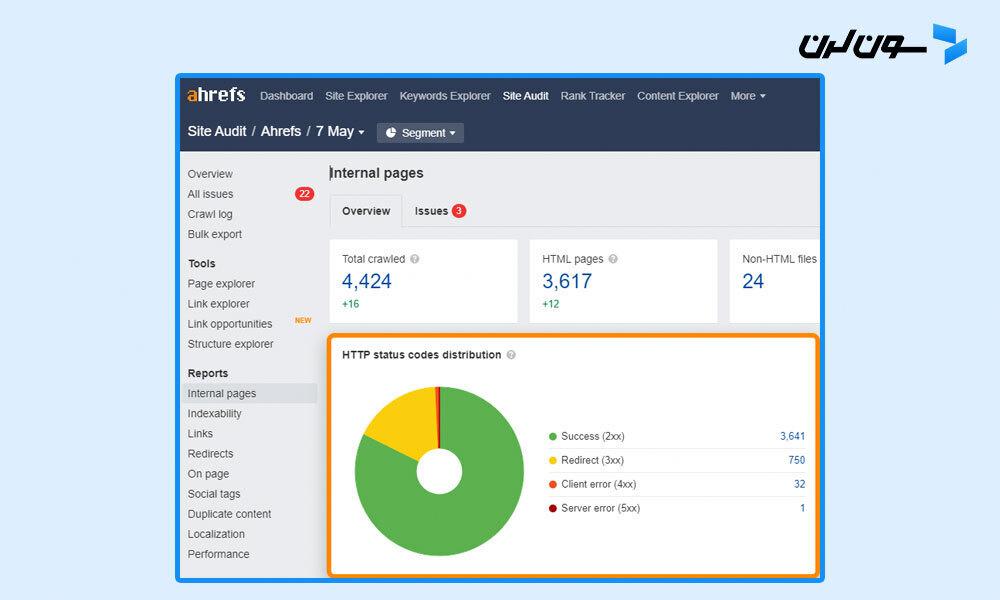

میتونی لینکهای ریدایرکت شده (3xx) رو توی گزارش صفحات داخلی در Site Audit پیدا کنی.

برای لینکهای ریدایرکت شده توی نقشه سایت، گزارش "All issues" رو برای مشکل "3XX redirect in sitemap" چک کن.

استفاده از GET به جای POST

این یه کم فنیتره و به روشهای درخواست HTTP مربوط میشه. از درخواستهای POST استفاده نکن وقتی که GET کار میکنه. اصولاً GET در مقابل POST هست. درخواستهای POST کش نمیشن پس روی بودجه خزش تاثیر میذارن، ولی درخواستهای GET میتونن کش بشن.

استفاده از API ایندکس

اگه نیاز داری صفحات سریعتر خزش بشن، بررسی کن ببین واجد شرایط استفاده از API ایندکس گوگل هستی یا نه. در حال حاضر این فقط برای چند مورد خاص مثل پستهای شغلی یا ویدیوهای زنده در دسترسه.

بینگ هم یه API ایندکس داره که برای همه قابل دسترسه.

استفاده از تگ Noindex

گوگل هنوز باید صفحات رو خزش کنه تا تگ noindex رو ببینه، ولی با تنظیمات خزششون ممکنه این صفحات رو به مرور زمان کمتر خزش کنن. اگه صفحاتی داری که نمیخوای ایندکس بشن، ممکنه ارزش داشته باشه که تگ noindex رو بهشون اضافه کنی.

کد 304 (Not Modified)

گوگلبات همیشه سرایندهای If-Modified-Since یا If-None-Match رو نمیفرسته. اگه این سرایندها رو بفرسته و سرورت با کد 304 (Not Modified) پاسخ بده، گوگل محتوای آخرین باری که خزش کرده رو استفاده میکنه.

این کار مقداری از منابع سرور رو کمتر مصرف میکنه، به این معنی که گوگل ممکنه بتونه بیشتر خزش کنه. با این حال، این تنظیمات فنی پیچیدهای داره و احتمالاً ارزشش رو نداره. بهتره روی تنظیمات کشینگ سایتت کار کنی تا اینکه این روش رو امتحان کنی.

چیزهایی که ممکنه کار کنه

این یه کم مشکوکه که آیا به بودجه خزش کمک میکنه یا نه.

Nofollow: در گذشته لینکهای nofollow بودجه خزش رو مصرف نمیکردن. اما حالا به عنوان یه نشونه توسط گوگل در نظر گرفته میشن، پس ممکنه این لینکها رو هم خزش کنه. همچنین ممکنه این لینکها رو به عنوان دنبال شده در صفحات دیگه وب پیدا کنه.

چیزهایی که کار نمیکنن

چند تا چیز هست که بعضیها امتحان میکنن ولی واقعاً به بودجه خزش کمک نمیکنه:

تغییرات کوچیک توی سایت: ایجاد تغییرات کوچیک روی صفحات مثل بهروزرسانی تاریخها، فاصلهها یا نشانهگذاریها به امید اینکه صفحات بیشتر خزش بشن. گوگل خیلی خوب تشخیص میده که آیا تغییرات مهم هستن یا نه، پس این تغییرات کوچیک احتمالاً تاثیری روی خزش ندارن.

دستور crawl-delay توی robots.txt: این دستور خزش خیلی از رباتها رو کند میکنه. ولی گوگلبات ازش استفاده نمیکنه پس تاثیری نداره. ما این دستور رو تو Ahrefs رعایت میکنیم، پس اگه نیاز داری خزش ما رو کند کنی میتونی توی فایل robots.txt اضافه کنی.

حذف اسکریپتهای شخص ثالث: اسکریپتهای شخص ثالث بودجه خزش رو مصرف نمیکنن، پس حذفشون کمکی نمیکنه.

چطور گوگل رو وادار کنیم کندتر خزش کنه

اگه میخوای گوگل کندتر خزش کنه، چند تا راهکار خوب هست که میتونی استفاده کنی. البته چند روش فنی دیگه هم هست مثل کند کردن سایت، ولی من این روشها رو توصیه نمیکنم.

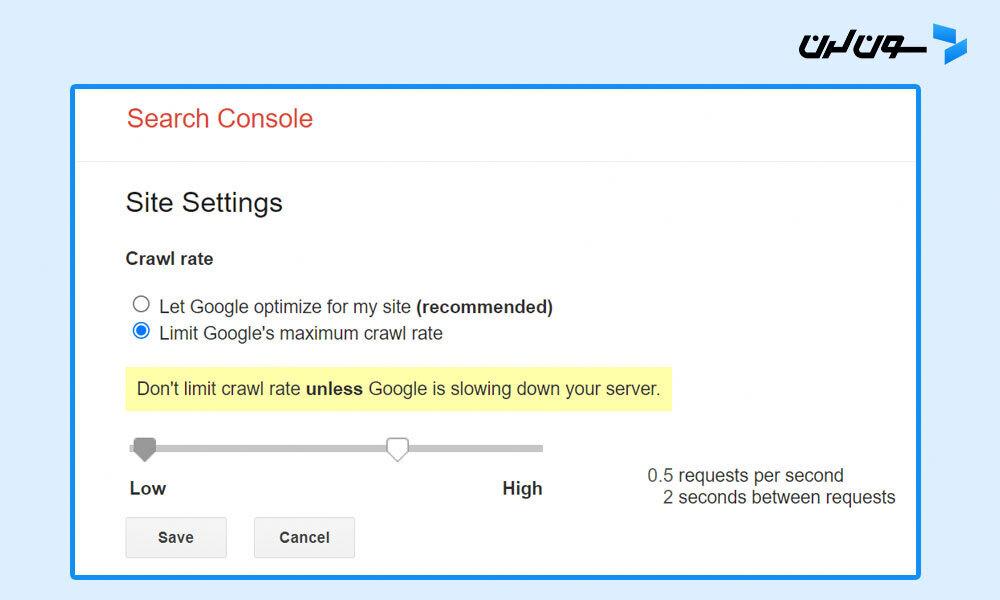

تنظیمات آهسته ولی تضمینی

اصلیترین کنترلی که گوگل بهمون میده تا خزش رو کندتر کنیم، یک محدودکننده نرخ توی Google Search Console هست. میتونی با این ابزار نرخ خزش رو کاهش بدی، ولی ممکنه تا دو روز طول بکشه تا اثر کنه.

تنظیمات سریع ولی با ریسک

اگه نیاز به یه راه حل فوریتر داری، میتونی از تنظیمات نرخ خزش گوگل مربوط به سلامت سایت استفاده کنی. اگه به گوگلبات کد وضعیت '503 Service Unavailable' یا '429 Too Many Requests' رو نشون بدی، اونا خزش رو کندتر میکنن یا ممکنه موقتاً متوقف کنن. ولی نمیخواد این کار رو بیشتر از چند روز انجام بدی، چون ممکنه صفحاتت رو از ایندکس حذف کنن.

گاهی تغییرات بزرگ روی سایت هم میتونه باعث بشه گوگل سریعتر خزش کنه. تغییرات همیشه با ریسک همراه هستن، پس این کار رو فقط به این دلیل که میخوای گوگل دوباره صفحاتت رو خزش کنه توصیه نمیکنم.

7 نکته برای بهینهسازی Crawl Budget

وقتی بدونی مشکلات بودجه خزش سایتت کجاست، میتونی اونا رو رفع کنی تا خزش سایتت بهینهتر بشه. اینجا چند تا از اصلیترین کارهایی که میتونی انجام بدی رو برات توضیح میدم:

1. سرعت سایتت رو بهبود بده

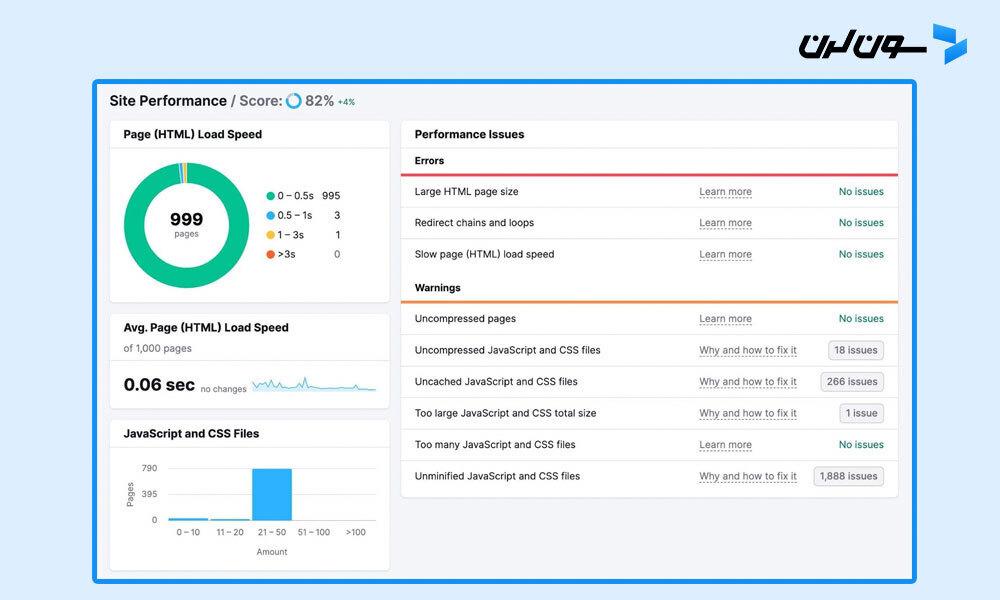

بهبود سرعت سایت میتونه کمک کنه گوگل سایتت رو سریعتر خزش کنه که این باعث استفاده بهینهتر از بودجه خزشت میشه. علاوه بر این، تجربه کاربری (UX) و سئوی سایتت هم بهتر میشه.

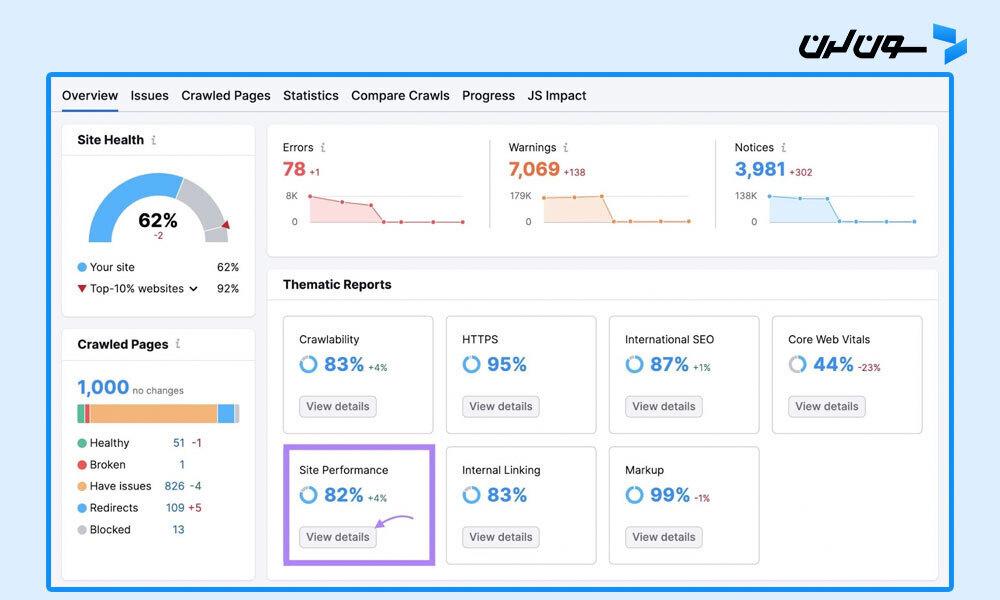

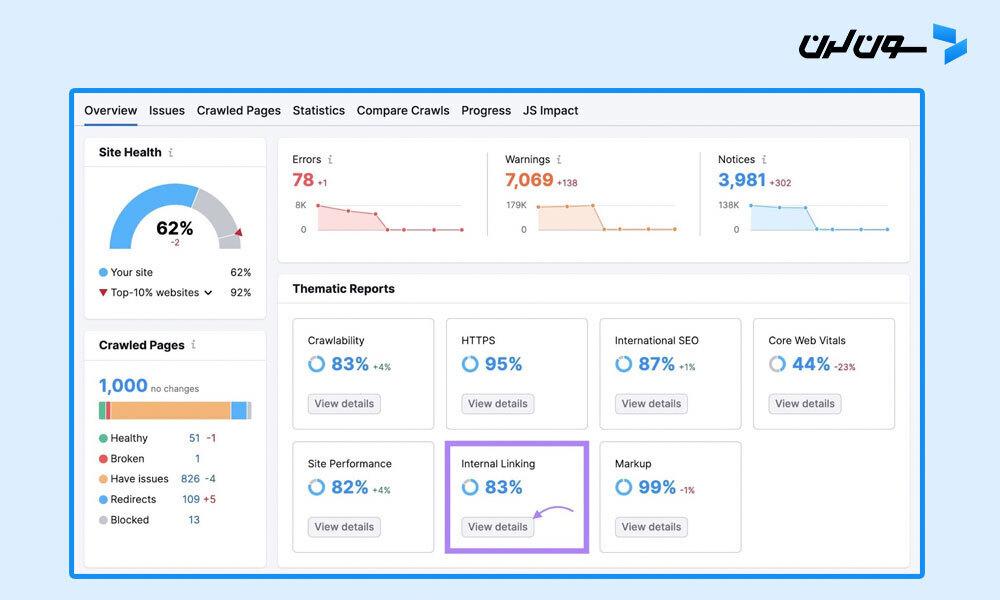

برای بررسی سرعت بارگذاری صفحات، به پروژه Site Audit که از قبل باید راهاندازی کرده باشی برو و روی “View details” در جعبه “Site Performance” کلیک کن.

اینجا یه تفکیک از سرعت بارگذاری صفحاتت و میانگین سرعت بارگذاری هر صفحه رو میبینی. به همراه یه لیست از خطاها و هشدارهایی که ممکنه منجر به عملکرد ضعیف سایتت شده باشن.

راههای زیادی برای بهبود سرعت صفحه وجود داره، از جمله:

- بهینهسازی تصاویر: از ابزارهای آنلاین مثل Image Compressor استفاده کن تا اندازه فایلها رو بدون افت کیفیت کاهش بدی.

- کمینهسازی کد و اسکریپتها: از ابزارهای آنلاین مثل Minifier.org یا پلاگینهای وردپرس مثل WP Rocket استفاده کن تا کدهای سایتت رو کمینه کنی و بارگذاری سریعتری داشته باشی.

- استفاده از شبکه تحویل محتوا (CDN): CDN یه شبکه توزیعشده از سرورهاست که محتوای وب رو براساس موقعیت کاربران تحویل میده تا سرعت بارگذاری بیشتر بشه.

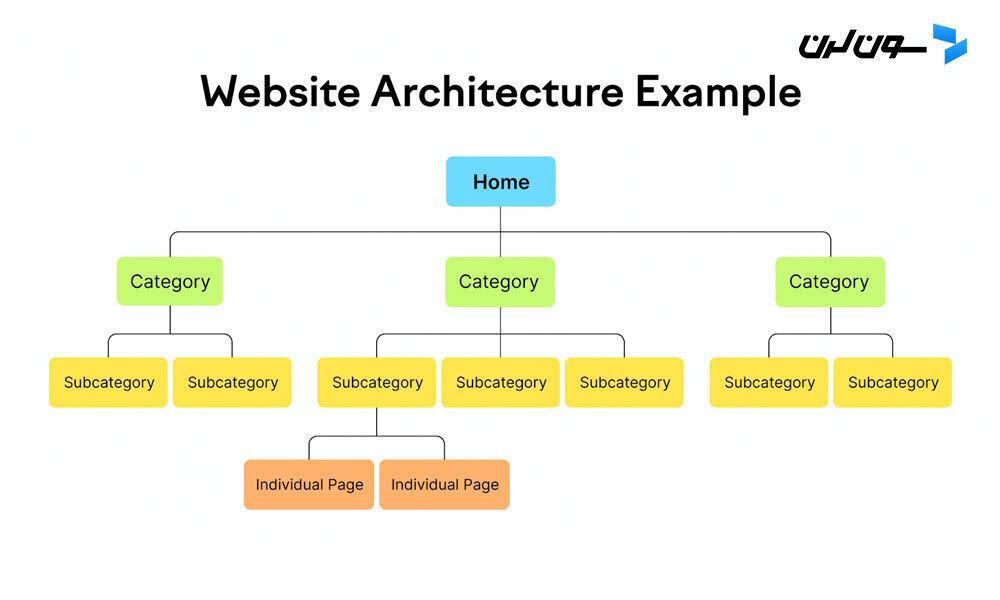

2. استفاده از لینکدهی داخلی استراتژیک

یه ساختار لینکدهی داخلی هوشمند میتونه به موتورهای جستجو کمک کنه تا محتوای سایتت رو بهتر پیدا کنن و بفهمن. این باعث میشه بودجه خزش بهینهتر استفاده بشه و پتانسیل رتبهبندی سایتت افزایش پیدا کنه.

سایتت رو مثل یه هرم تصور کن، با صفحه اصلی در بالای هرم. از اونجا به دستهها و زیرمجموعههای مختلف شاخهبندی میشه.

هر شاخه باید به صفحات یا پستهای جزئیتر مربوط به دستهای که توش قرار دارن، منتهی بشه.

این ساختار واضح و منطقی برای سایتت ایجاد میکنه که هم برای کاربران و هم برای موتورهای جستجو راحتتر قابل پیمایشه.

لینکهای داخلی به تمام صفحات مهم اضافه کن تا گوگل راحتتر محتوای مهمت رو پیدا کنه.

این کار همچنین بهت کمک میکنه از صفحات بدون لینک داخلی جلوگیری کنی. گوگل میتونه این صفحات رو پیدا کنه، ولی خیلی راحتتره اگه لینکهای داخلی مرتبط داشته باشن.

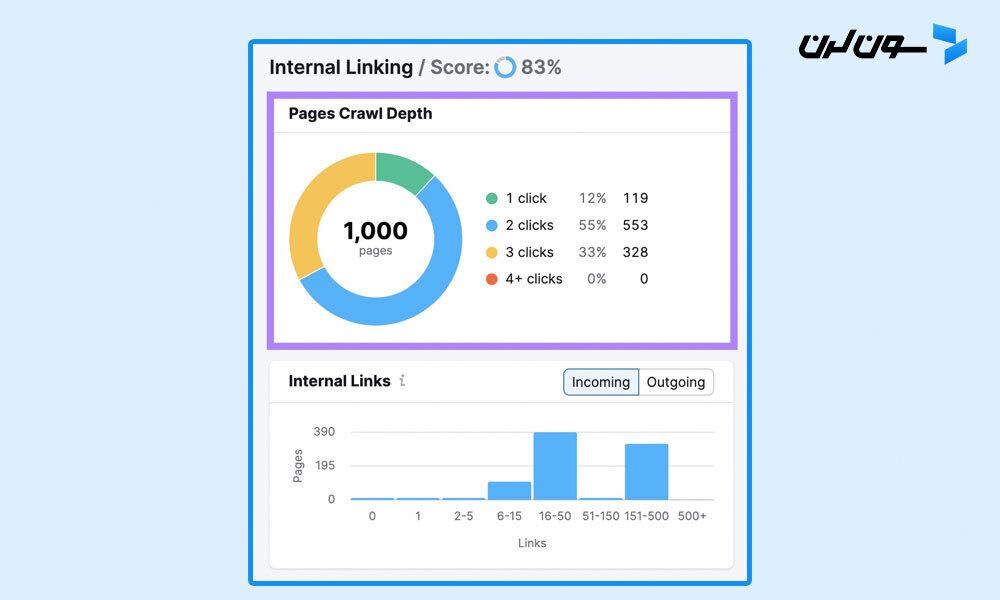

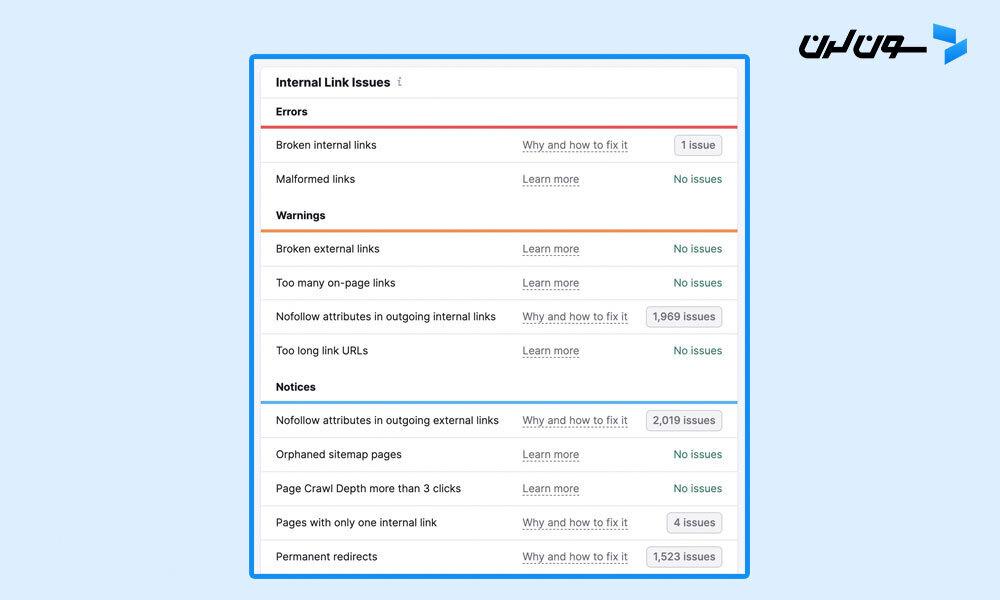

روی “View details” در جعبه "Internal Linking” در پروژه Site Audit کلیک کن تا مشکلات لینکدهی داخلی رو پیدا کنی.

نمایی کلی از ساختار لینکدهی داخلی سایتت رو میبینی. شامل تعداد کلیکهایی که از صفحه اصلی برای رسیدن به هر صفحه لازمه.

یه لیست از خطاها، هشدارها و نکات هم میبینی. اینا مشکلاتی مثل لینکهای خراب، ویژگیهای nofollow روی لینکهای داخلی و لینکهای بدون متن انکر رو پوشش میدن.

این مشکلات رو برای هر صفحه بررسی و رفع کن تا موتورهای جستجو راحتتر بتونن محتوای سایتت رو خزش و ایندکس کنن.

3. نقشه سایتت رو بهروز نگه دار

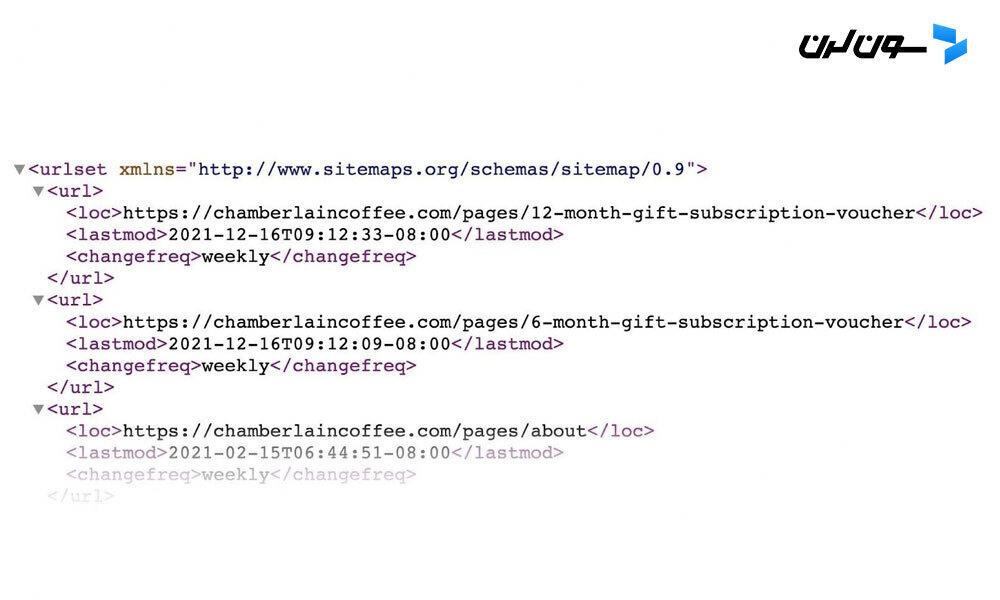

داشتن یک نقشه سایت XML بهروز یکی دیگه از راههایی هست که میتونی گوگل رو به صفحات مهمت هدایت کنی. با بهروزرسانی نقشه سایت وقتی صفحات جدید اضافه میکنی، احتمال خزش اون صفحات بیشتر میشه (البته تضمینی نیست).

نقشه سایتت ممکنه شبیه به این باشه (بسته به نحوه ایجادش ممکنه متفاوت باشه):

گوگل توصیه میکنه فقط URLهایی که میخوای تو نتایج جستجو ظاهر بشن رو تو نقشه سایتت بذاری تا از هدر رفتن بودجه خزش جلوگیری بشه.

همچنین میتونی از تگ <lastmod> استفاده کنی تا نشون بدی آخرین باری که یک URL رو بهروزرسانی کردی کی بوده، ولی ضروری نیست.

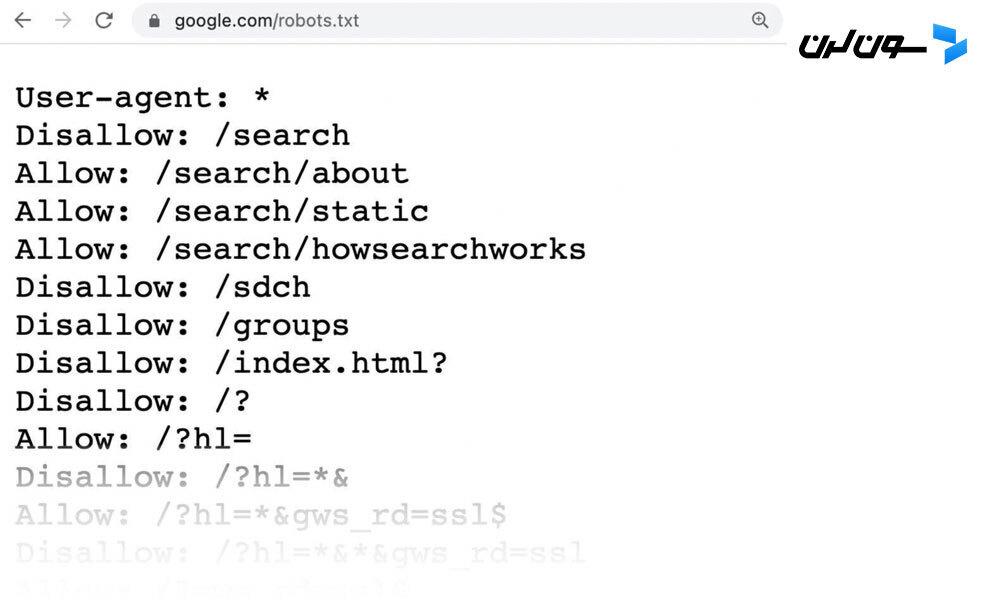

4. مسدود کردن URLهایی که نمیخوای موتورهای جستجو خزش کنن

از فایل robots.txt (فایلی که به رباتهای موتور جستجو میگه کدوم صفحات باید و کدوم نباید خزش بشن) استفاده کن تا احتمال خزش صفحات غیرضروری توسط گوگل رو کم کنی. این کار میتونه از هدر رفتن بودجه خزش جلوگیری کنه.

چرا باید خزش بعضی صفحات رو متوقف کنی؟

چون بعضی صفحات اهمیت زیادی ندارن یا خصوصی هستن و احتمالاً نمیخوای موتورهای جستجو این صفحات رو خزش کنن و منابعشون رو هدر بدن.

اینجا یه نمونه از فایل robots.txt هست:

همه صفحاتی که بعد از “Disallow:” اومده، صفحاتی هستن که نمیخوای موتورهای جستجو خزش کنن.

توجه: میتونی صفحات رو با تگ متای “noindex” هم مسدود کنی، ولی گوگل همچنان سعی میکنه این صفحات رو خزش کنه و بودجه خزش رو هدر میده. در حالی که noindex برای مقاصد دیگه میتونه مفید باشه، گوگل توصیه نمیکنه ازش برای مدیریت بودجه خزش استفاده کنی.

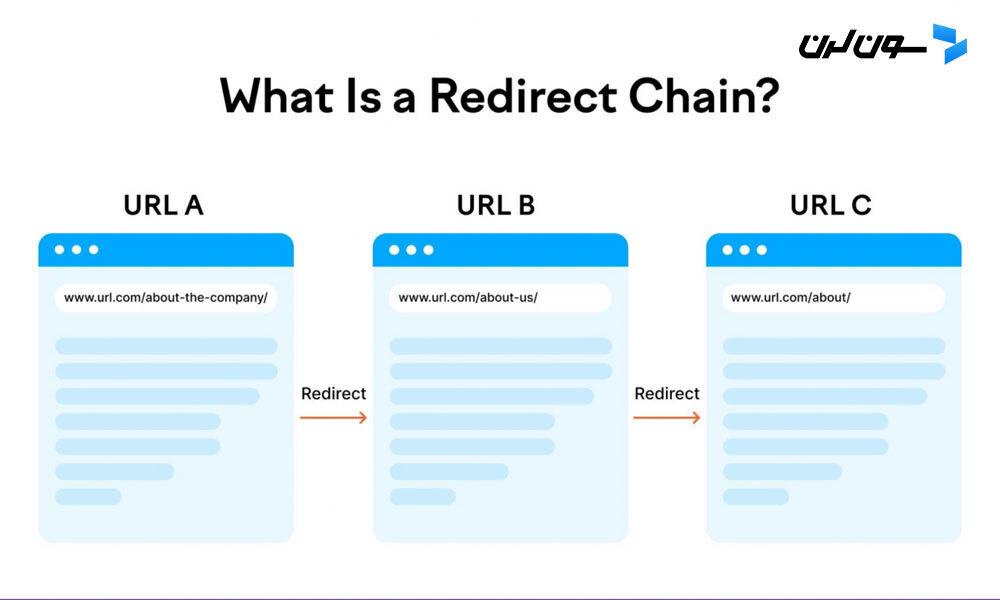

5. حذف ریدایرکتهای غیرضروری

ریدایرکتها کاربران (و رباتها) رو از یک URL به URL دیگه میبرن و میتونن زمان بارگذاری صفحه رو کاهش بدن و بودجه خزش رو هدر بدن.

این موضوع بهخصوص وقتی مشکلساز میشه که زنجیرههای ریدایرکت داشته باشی. اینها وقتی رخ میده که بیش از یک ریدایرکت بین URL اصلی و URL نهایی داشته باشی.

مثل این:

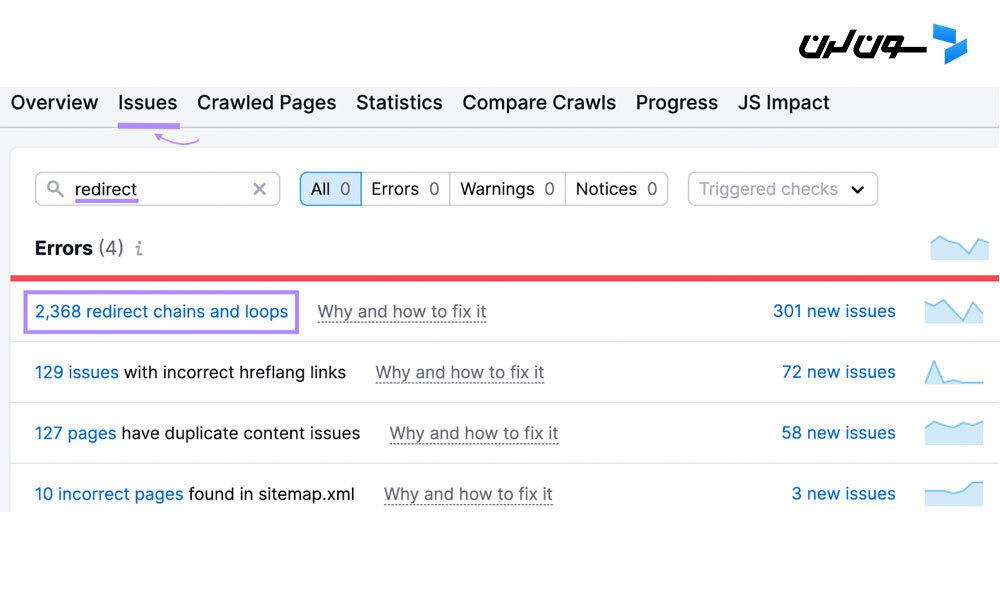

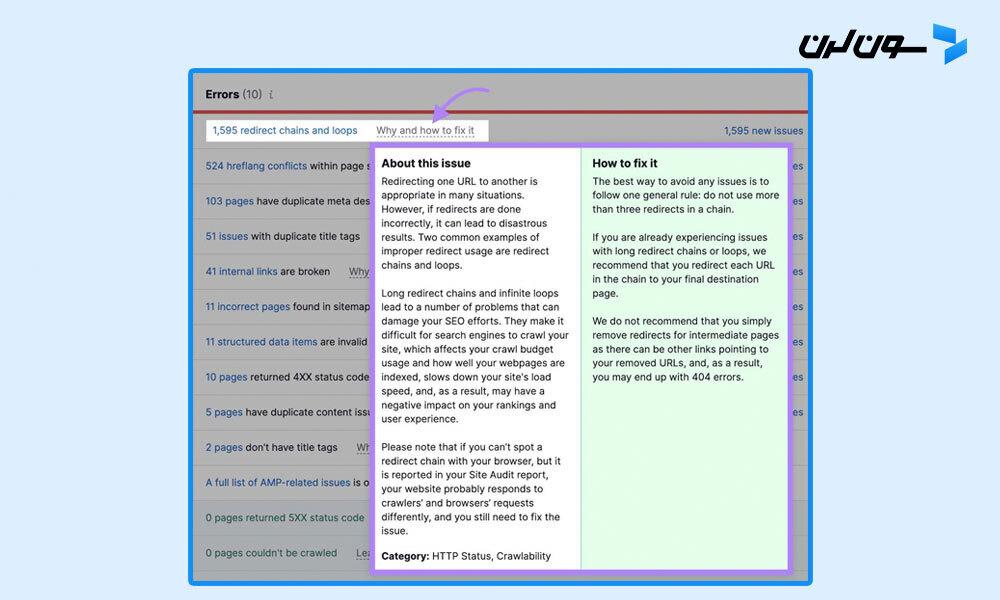

برای اطلاعات بیشتر درباره ریدایرکتهای سایتت، ابزار Site Audit رو باز کن و به تب “Issues” برو.

کلمه “redirect” رو توی نوار جستجو وارد کن تا مشکلات مربوط به ریدایرکتهای سایتت رو ببینی.

روی “Why and how to fix it” یا “Learn more” کلیک کن تا اطلاعات بیشتری درباره هر مشکل بگیری و راهنماییهایی برای رفعشون ببینی.

6. لینکهای شکسته رو رفع کن

لینکهای شکسته لینکهایی هستن که به صفحات غیرموجود هدایت میشن و معمولاً کد خطای 404 برمیگردونن.

این لزوماً چیز بدی نیست. در واقع، صفحاتی که وجود ندارن باید کد وضعیت 404 برگردونن.

اما داشتن تعداد زیادی لینک شکسته که به صفحات غیرموجود هدایت میشن، بودجه خزش رو هدر میده. چون رباتها ممکنه همچنان سعی کنن این صفحات رو خزش کنن، حتی اگه چیزی با ارزش توشون نباشه. و این برای کاربرانی که این لینکها رو دنبال میکنن هم ناراحتکننده هست.

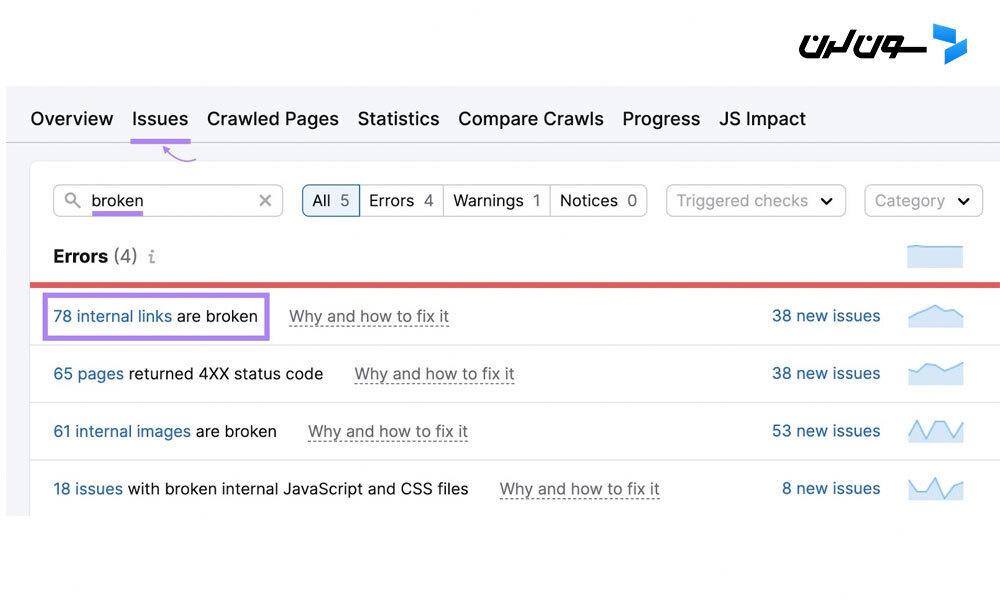

برای شناسایی لینکهای شکسته سایتت، به تب “Issues” در Site Audit برو و کلمه “broken” رو توی نوار جستجو وارد کن.

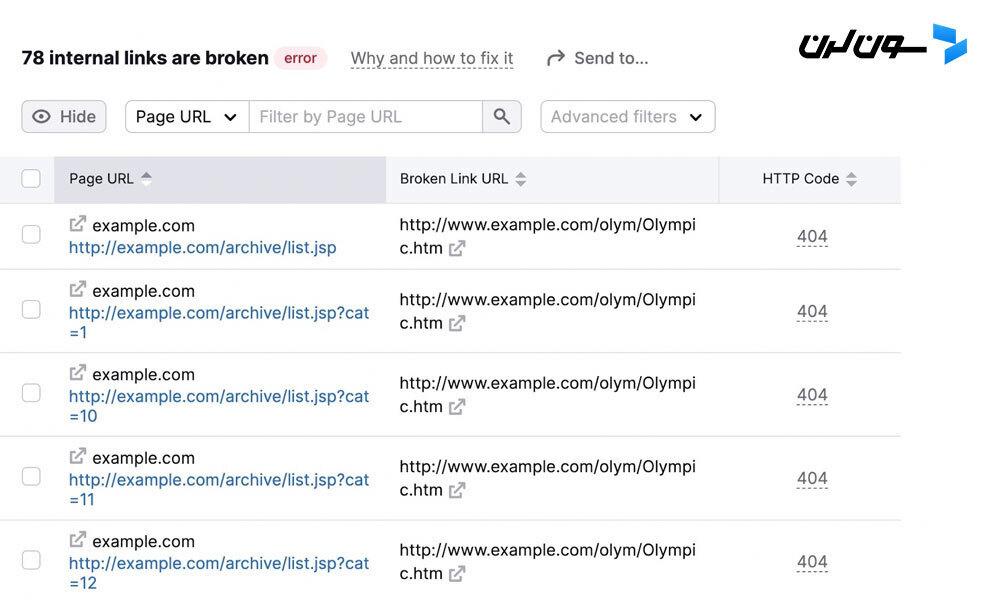

به دنبال خطای “# internal links are broken” باش. اگه این خطا رو دیدی، روی لینک آبی روی عدد کلیک کن تا جزئیات بیشتری ببینی.

سپس لیستی از صفحات سایتت با لینکهای شکسته رو میبینی. به همراه لینکهای خاص هر صفحه که شکسته هستن.

این صفحات رو بررسی و لینکهای شکسته رو اصلاح کن تا قابلیت خزش سایتت بهتر بشه.

7. محتوای تکراری رو حذف کن

محتوای تکراری زمانی اتفاق میافته که صفحات بسیار مشابهی توی سایتت داشته باشی. این مسئله میتونه بودجه خزش رو هدر بده چون رباتها عملاً چند نسخه از یک صفحه رو خزش میکنن.

محتوای تکراری میتونه به چند شکل باشه. مثل صفحات کاملاً مشابه یا تقریباً مشابه (که معمولاً باید ازشون اجتناب کنی). یا تنوعهای صفحات به خاطر پارامترهای URL (معمول در وبسایتهای تجارت الکترونیک).

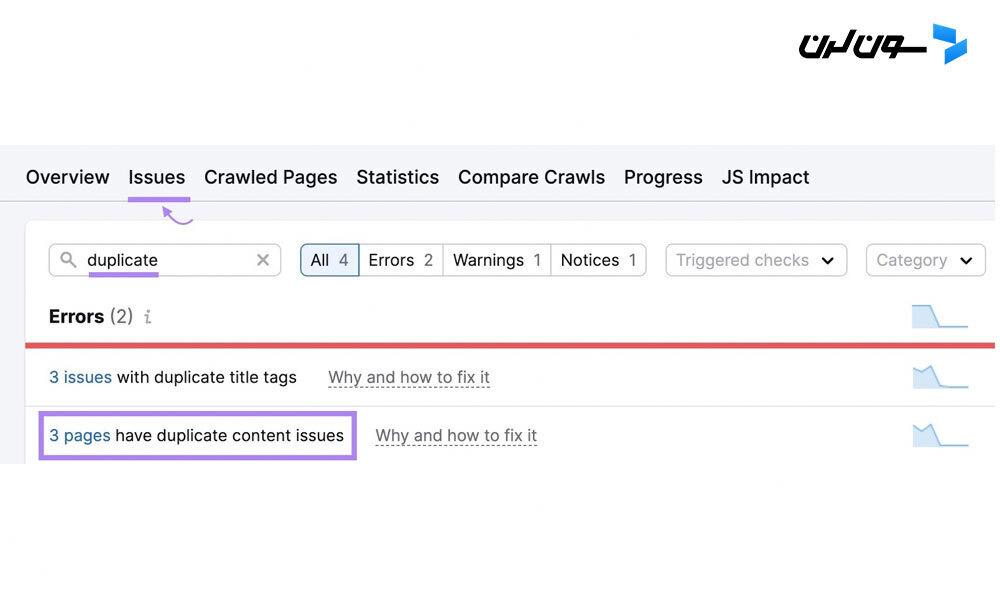

برای دیدن اینکه آیا سایتت مشکل محتوای تکراری داره، به تب “Issues” در Site Audit برو.

اگه مشکلی هست، این گزینهها رو در نظر بگیر:

- از تگهای “rel=canonical” توی کد HTML استفاده کن تا به گوگل بگی کدوم صفحه باید تو نتایج جستجو ظاهر بشه.

- یه صفحه رو به عنوان صفحه اصلی انتخاب کن (مطمئن شو هر چیزی که توی صفحات اضافی هست و توی صفحه اصلی نیست رو اضافه کنی). بعد، از ریدایرکتهای 301 برای ریدایرکت کردن صفحات تکراری استفاده کن.

سوالات متداول

1. Crawl Budget چیه و چرا اهمیت داره؟

Crawl Budget یا بودجه خزش، تعداد صفحاتی هست که گوگل تو یه بازه زمانی مشخص تو سایتت خزش میکنه. این مفهوم برای سئو خیلی مهمه، چون اگه صفحات سایتت مرتب خزش نشن، ممکنه تو نتایج جستجو نمایش داده نشن و ترافیک ارگانیک سایتت کم بشه.

2. چطور میتونم بودجه خزش سایت خودمو بهینه کنم؟

برای بهینهسازی بودجه خزش سایت، میتونی سرعت سایتتو بهبود بدی، لینکهای داخلی و خارجی بیشتری بسازی، نقشه سایتتو بهروز نگه داری، لینکهای شکسته رو رفع کنی و محتوای تکراری رو حذف کنی. همچنین میتونی از فایل robots.txt برای مسدود کردن صفحاتی که نمیخوای گوگل خزش کنه استفاده کنی.

3. چرا باید لینکهای شکسته رو اصلاح کنم؟

لینکهای شکسته باعث هدر رفتن بودجه خزش میشن، چون رباتهای موتور جستجو همچنان سعی میکنن این صفحات رو خزش کنن. علاوه بر این، لینکهای شکسته تجربه کاربری رو هم خراب میکنن و میتونن روی رتبهبندی سایتت تاثیر منفی بذارن.

جمعبندی

بهینهسازی Crawl Budget یکی از مهمترین بخشهای سئو هست که میتونه به بهبود رتبه سایتت تو نتایج جستجو کمک کنه. با رعایت نکاتی که تو این مقاله گفتم، میتونی مطمئن بشی که سایتت به بهترین نحو ممکن توسط گوگل خزش و ایندکس میشه. یادت باشه که بهبود سرعت سایت، مدیریت لینکهای داخلی و خارجی، بهروز نگه داشتن نقشه سایت، رفع لینکهای شکسته و حذف محتوای تکراری، همگی اقداماتی هستن که میتونن به بهینهسازی بودجه خزش کمک کنن.

دوره الفبای برنامه نویسی با هدف انتخاب زبان برنامه نویسی مناسب برای شما و پاسخگویی به سوالات متداول در شروع یادگیری موقتا رایگان شد: