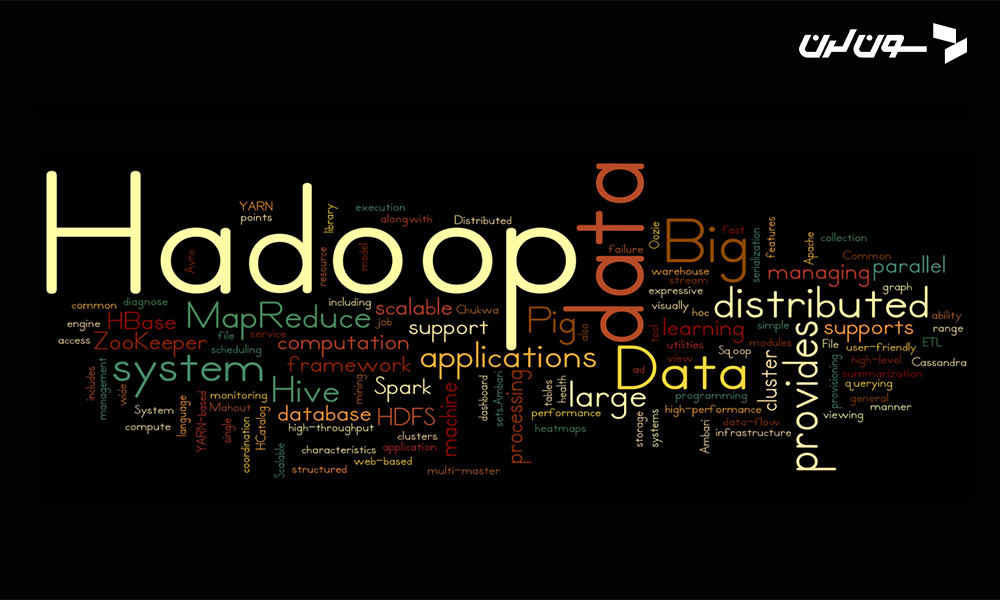

- Hadoop چیست؟

- چرا Hadoop مهمه؟

- جهان بدون Hadoop

- تاریخچه Hadoop

- تاثیر Hadoop بر دنیای فناوری

- کاربردهای گسترده Hadoop

- مزایای Hadoop

- معایب Hadoop

- کاربردهای Hadoop

- مجموعه ابزارهای کاربردی برای Hadoop

- مثالهای کدنویسی با Hadoop

- شرکتهای معروف استفاده کننده از Hadoop

- سوالات متداول

- جمع بندی

تصور کن که در یک شرکت بزرگ کار میکنی و مسئولیت مدیریت حجم عظیمی از دادهها به تو سپرده شده. هر روز این دادهها بیشتر و بیشتر میشوند و تو باید راهی پیدا کنی که این حجم از اطلاعات را به راحتی پردازش و تحلیل کنی. در چنین شرایطی، استفاده از تکنولوژیهای پیشرفته و کارآمد برای مدیریت دادهها ضروری است. حالا بیایید به اوایل دهه ۲۰۰۰ برگردیم، زمانی که همین مشکل برای شرکتهای بزرگی مثل گوگل و یاهو وجود داشت. این شرکتها باید با حجم وسیعی از دادهها کار میکردند و نیاز داشتند راه حلی برای این چالش پیدا کنند.

Hadoop چیست؟

حالا وقتشه که دقیقتر بفهمیم Hadoop چیه و چطور به مدیریت دادههای بزرگ کمک میکنه. Hadoop یک چارچوب نرم افزاری اپن سورس برای ذخیره سازی و پردازش دادههای بزرگ (Big Data) هست. این چارچوب از دو بخش اصلی تشکیل شده: سیستم فایل توزیع شده Hadoop (HDFS) و مدل برنامه نویسی MapReduce.

HDFS: سیستم فایل توزیع شده

HDFS یا همون "Hadoop Distributed File System" مثل قفسههای یک کتابخونه خیلی بزرگه. این سیستم فایل به شما اجازه میده دادهها رو در چندین سرور ذخیره کنی. تصور کن داده هات مثل تکههای پازل هستند که توی چندین قفسه مختلف قرار میگیرن. اینطوری، اگه یکی از سرورها خراب بشه، تکههای دیگه پازل هنوز سالم هستن و میتونی به راحتی به داده هات دسترسی داشته باشی. HDFS این قابلیت رو داره که با خرابیهای سخت افزاری مقابله کنه و دادهها رو به صورت قابل اعتمادی ذخیره کنه.

MapReduce: مدل برنامه نویسی

MapReduce یک مدل برنامه نویسیه که به شما اجازه میده عملیات پردازشی رو روی دادههای بزرگ به صورت موازی انجام بدی. این مدل برنامه نویسی به دو بخش اصلی تقسیم میشه: Map و Reduce. در مرحله Map، دادهها به قطعات کوچکتر تقسیم میشن و هر قطعه به صورت جداگانه پردازش میشه. این پردازشها میتونن به صورت همزمان روی چندین سرور انجام بشن که باعث افزایش سرعت و کارایی میشه. سپس در مرحله Reduce، نتایج به دست اومده از مرحله Map ترکیب میشن تا نتیجه نهایی به دست بیاد. به زبان ساده تر، MapReduce به شما کمک میکنه تا حجم عظیمی از دادهها رو به صورت سریع و کارآمد تحلیل کنی.

چرا Hadoop مهمه؟

حالا که با HDFS و MapReduce آشنا شدی، شاید از خودت بپرسی چرا Hadoop اینقدر مهمه. با رشد روزافزون داده ها، شرکتها نیاز دارن تا به سرعت و با دقت این اطلاعات رو پردازش و تحلیل کنن. Hadoop این امکان رو به شرکتها میده تا با هزینه کمتر و کارایی بیشتر این کار رو انجام بدن. از تجزیه و تحلیل دادههای مالی تا پردازش اطلاعات کاربران در شبکههای اجتماعی، Hadoop در هر صنعتی کاربرد داره و ابزارهای قدرتمندی رو برای مدیریت دادههای بزرگ فراهم میکنه.

جهان بدون Hadoop

حالا تصور کن اگر Hadoop وجود نداشت، چه اتفاقی میافتاد؟ هر بار که میخواستی جستجویی در گوگل انجام بدی، باید ساعتها صبر میکردی تا نتایج برات نمایش داده بشن. یا اگه میخواستی یک ویدیو در یوتیوب ببینی، شاید مجبور میشدی روزها منتظر بمونی تا ویدیو لود بشه. بدون Hadoop، همه این کارها به شدت پیچیده و زمان بر میشدن و عملاً استفاده راحت و سریع از سرویسهای آنلاین ممکن نبود. جهان فناوری به گونه ای که امروز میشناسیم، بدون Hadoop بسیار متفاوت و احتمالاً کندتر بود.

تاریخچه Hadoop

Hadoop در سال ۲۰۰۶ توسط دوگ کاتینگ و مایک کافارلا ساخته شد. ایده اصلی Hadoop از یک مقاله تحقیقاتی گوگل در مورد سیستم فایل Google File System (GFS) و MapReduce گرفته شده بود. این تکنولوژی برای مدیریت و پردازش دادههای بزرگ به وجود اومد و به سرعت تبدیل به یکی از مهمترین ابزارهای دنیای فناوری شد. Hadoop امکان پردازش موازی و توزیع شده دادهها رو فراهم میکنه، که به شرکتها اجازه میده دادههای بزرگ رو به سرعت و کارایی بالا پردازش کنن.

تاثیر Hadoop بر دنیای فناوری

Hadoop با ارائه روشی نوین برای ذخیره سازی و پردازش داده ها، انقلاب بزرگی در دنیای فناوری ایجاد کرد. این تکنولوژی به شرکتها امکان داد تا به راحتی با حجم عظیمی از دادهها کار کنن و از این دادهها برای بهبود سرویسها و محصولات خودشون بهره ببرن. برای مثال، سرویسهای جستجوی گوگل با استفاده از Hadoop میتونن در عرض چند ثانیه به میلیونها پرسش پاسخ بدن. همچنین، پلتفرمهای ویدیویی مثل یوتیوب میتونن هزاران ویدیو رو به صورت همزمان پردازش و به کاربران ارائه بدن.

کاربردهای گسترده Hadoop

Hadoop تنها به شرکتهای بزرگ محدود نمیشه. بسیاری از شرکتهای کوچک و متوسط هم از این تکنولوژی برای مدیریت دادههای خودشون استفاده میکنن. از تحلیل دادههای بازار تا مدیریت لاگهای سیستم، Hadoop در بسیاری از حوزهها کاربرد داره. این تکنولوژی به کسب و کارها امکان میده تا دادههای خودشون رو به صورت موثرتری مدیریت کنن و از این دادهها برای تصمیم گیریهای استراتژیک استفاده کنن.

در نهایت، Hadoop نقش بسیار مهمی در پیشرفت دنیای فناوری داشته و بدون اون، بسیاری از سرویسها و محصولاتی که امروز به اونها وابسته ایم، وجود نداشتند یا عملکرد بسیار ضعیفتری داشتند. این تکنولوژی همچنان در حال تکامله و هر روز کاربردهای جدیدتری پیدا میکنه، که نشون دهنده اهمیت و تاثیر عمیق اون بر دنیای امروز است.

مزایای Hadoop

Hadoop یک تکنولوژی پیشرفته و قدرتمنده که به شرکتها کمک میکنه دادههای بزرگ خودشون رو به بهترین شکل مدیریت کنن. بیایید با هم به چند تا از این مزایا نگاه کنیم.

مقیاس پذیری

یکی از بزرگترین مزایای Hadoop، مقیاس پذیری اونه. تصور کنید هر روز حجم عظیمی از دادهها به سرورهای شما وارد میشه و شما نیاز دارید که این دادهها رو بدون مشکل و به سرعت پردازش کنید. Hadoop این امکان رو فراهم میکنه که با افزایش حجم داده ها، سیستم شما به راحتی مقیاس پذیر باشه. یعنی شما میتونید تعداد سرورها رو افزایش بدید و دادهها رو به صورت موازی در این سرورها پردازش کنید، بدون اینکه نیازی به تغییرات اساسی در ساختار سیستم داشته باشید. این مقیاس پذیری به شما این امکان رو میده که بدون نگرانی از افزایش حجم داده ها، همچنان به کار خود ادامه بدید.

هزینه کم

یکی دیگه از مزایای بزرگ Hadoop، هزینه پایین اونه. چون Hadoop یک پروژه اپن سورس هست، استفاده از اون به شما اجازه میده که بدون نیاز به خرید لایسنسهای گران قیمت، ازش بهره ببرید. این ویژگی به ویژه برای استارتاپها و شرکتهای کوچیک که منابع مالی محدودی دارن، خیلی مهمه. علاوه بر این، با استفاده از سخت افزارهای معمولی و ارزان قیمت هم میتونید یک خوشه Hadoop راه اندازی کنید و به نتایج عالی دست پیدا کنید. این کاهش هزینهها به شرکتها این امکان رو میده که بدون نیاز به سرمایه گذاریهای سنگین، از مزایای بزرگ دادهها بهره مند بشن.

انعطاف پذیری

Hadoop خیلی انعطاف پذیره و میتونه انواع مختلف داده ها، اعم از ساخت یافته و غیرساخت یافته رو پردازش کنه. یعنی شما میتونید دادههای متنی، ویدیویی، صوتی و حتی دادههای وبلاگها و شبکههای اجتماعی رو به راحتی در Hadoop ذخیره و پردازش کنید. این ویژگی به شما این امکان رو میده که به سرعت و به صورت موثر به تحلیل دادههای مختلف بپردازید و از اونها برای بهبود کسب و کار خود استفاده کنید. مثلاً میتونید دادههای مشتریان خود رو تحلیل کنید و بفهمید که چه محصولاتی بیشتر مورد توجه اونها قرار میگیره.

مقاومت در برابر خطا

Hadoop طوری طراحی شده که در برابر خرابیهای سخت افزاری مقاوم باشه. HDFS یا همون سیستم فایل توزیع شده Hadoop، دادهها رو به تکههای کوچکتر تقسیم میکنه و هر تکه رو در چندین سرور ذخیره میکنه. این کار باعث میشه که اگر یکی از سرورها خراب بشه، دادهها همچنان در دسترس باشن و از روی سرورهای دیگه بازیابی بشن. این ویژگی Hadoop رو به یک ابزار بسیار قابل اعتماد برای ذخیره سازی دادههای بزرگ تبدیل کرده. بنابراین، شما میتونید با اطمینان خاطر از اینکه داده هاتون در صورت بروز هرگونه مشکلی همچنان قابل دسترس هستن، به کار خود ادامه بدید.

معایب Hadoop

با همه مزایایی که Hadoop داره، این تکنولوژی هم معایب خودش رو داره که باید بهشون توجه کنیم. بیایید با هم به این معایب نگاهی بندازیم.

پیچیدگی

با وجود تمامی مزایا، Hadoop همچنان میتونه برای برخی از افراد پیچیده باشه. کار با Hadoop نیاز به یادگیری و تجربه داره و ممکنه برای کسانی که تازه با این تکنولوژی آشنا شدن، کمی دلهره آور باشه. یادگیری مفاهیمی مثل HDFS و MapReduce و تنظیمات پیچیده Hadoop، نیازمند زمان و تمرینه. به همین دلیل، شرکتها ممکنه نیاز به استخدام متخصصان ماهر در زمینه Hadoop داشته باشن یا دورههای آموزشی مناسبی برای کارکنان خود برگزار کنن. این پیچیدگی میتونه در ابتدا کمی چالش برانگیز باشه، اما با گذشت زمان و کسب تجربه، میشه از مزایای بی نظیر Hadoop بهره برد.

سرعت پردازش

در برخی موارد، سرعت پردازش Hadoop ممکنه کمتر از راه حلهای تجاری دیگه باشه. اگرچه Hadoop میتونه حجم عظیمی از دادهها رو به صورت موازی پردازش کنه، اما برای برخی از وظایف خاص، ممکنه راه حلهای دیگه مثل پردازش در حافظه (In-Memory Processing) سریعتر عمل کنن. بنابراین، برای برخی از کاربردها ممکنه نیاز باشه که از ترکیب Hadoop با سایر تکنولوژیها استفاده کنید تا به بهترین عملکرد دست پیدا کنید. این به معنای اینه که Hadoop به تنهایی ممکنه نتونه تمامی نیازهای پردازشی شما رو برآورده کنه و نیاز به یک استراتژی ترکیبی داشته باشید.

کاربردهای Hadoop

Hadoop در بسیاری از زمینهها و صنایع کاربرد داره و به شرکتها این امکان رو میده که دادههای بزرگ خودشون رو به بهترین شکل ممکن مدیریت و تحلیل کنن. بیایید نگاهی به چند نمونه از کاربردهای مهم Hadoop بندازیم.

تحلیل دادههای بزرگ

یکی از مهمترین کاربردهای Hadoop، تحلیل دادههای بزرگه. شرکت هایی مثل فیس بوک و توییتر از Hadoop برای تحلیل دادههای کاربران خود استفاده میکنن. این شرکتها میتونن با تحلیل دادههای حجیم، الگوهای رفتاری کاربران رو شناسایی کرده و خدمات خود رو بهبود بدن. برای مثال، فیس بوک از Hadoop برای تحلیل پست ها، لایکها و کامنتهای کاربران استفاده میکنه تا محتوای مرتبطتری به اونها نمایش بده. این تحلیلها به فیس بوک کمک میکنه تا تبلیغات هدفمندی رو به کاربران نشون بده و تجربه کاربری بهتری رو فراهم کنه.

ذخیره سازی داده ها

Hadoop برای ذخیره سازی دادههای بزرگ هم به کار میره. شرکت هایی مثل آمازون از Hadoop برای ذخیره سازی دادههای مربوط به خرید و فروش آنلاین استفاده میکنن. با استفاده از HDFS، آمازون میتونه دادههای مربوط به تراکنش ها، محصولات و مشتریان رو به صورت توزیع شده ذخیره کنه و از این دادهها برای تحلیل بازار و بهبود خدمات خود بهره ببره. این ذخیره سازی توزیع شده به آمازون این امکان رو میده که با اطمینان خاطر از سلامت داده ها، به تحلیل و استفاده از اونها بپردازه.

پردازش زبان طبیعی

Hadoop در پردازش زبان طبیعی (NLP) هم کاربرد داره. شرکت هایی مثل گوگل از Hadoop برای بهبود الگوریتمهای جستجوی خودشون استفاده میکنن. با پردازش حجم عظیمی از دادههای متنی، گوگل میتونه الگوریتمهای جستجوی خود رو بهبود بده و نتایج دقیقتری به کاربران ارائه بده. برای مثال، با تحلیل دادههای جستجوهای کاربران، گوگل میتونه پیش بینی کنه که کاربران به دنبال چه اطلاعاتی هستن و نتایج مرتبطتری رو نمایش بده. این بهبودها به گوگل کمک میکنه تا تجربه جستجوی بهتری رو برای کاربران فراهم کنه و پاسخهای دقیقتری به نیازهای اونها ارائه بده.

در نهایت، Hadoop با ارائه ابزارهای قدرتمند برای ذخیره سازی و پردازش دادههای بزرگ، به شرکتها امکان میده که از دادههای خودشون به بهترین شکل ممکن استفاده کنن و تصمیمات بهتری بگیرن. این تکنولوژی همچنان در حال پیشرفته و هر روز کاربردهای جدیدتری پیدا میکنه که نشون دهنده اهمیت و تاثیر عمیق اون بر دنیای امروز هست.

مجموعه ابزارهای کاربردی برای Hadoop

اگه دوست داری از هدوپ به بهترین شکل استفاده کنی، باید با یه سری ابزارهای جانبی آشنا بشی که میتونن کلی بهت کمک کنن. این ابزارها قابلیتهای هدوپ رو افزایش میدن و کار با دادههای بزرگ رو راحتتر میکنن. حالا بیایید با هم این ابزارها رو بررسی کنیم و ببینیم هر کدوم چه کاری انجام میده.

Apache Pig

اول از همه، بریم سراغ Apache Pig. Pig یک پلتفرم برای تحلیل دادههای بزرگه که از زبان اسکریپت نویسی به نام Pig Latin استفاده میکنه. این زبان خیلی شبیه به SQL نیست، اما خیلی قدرتمنده و میتونه پردازشهای پیچیده رو روی دادهها انجام بده. مثلا فرض کن دادههای مربوط به فروش یه فروشگاه بزرگ رو داری و میخوای الگوی خرید مشتریها رو پیدا کنی، با Pig میتونی به راحتی این کار رو انجام بدی.

Apache Hive

حالا بریم سراغ Apache Hive. اگه با SQL آشنایی داری، عاشق Hive میشی. Hive بهت اجازه میده که با استفاده از دستورات SQL دادههای بزرگ رو پردازش و تحلیل کنی. مثلا میتونی کوئریهای پیچیده ای روی دادههای خودت اجرا کنی و نتایج رو به راحتی ببینی. این ابزار مخصوصا برای تحلیل دادههای ساخت یافته و نیمه ساخت یافته خیلی مفیده.

Apache HBase

Apache HBase یه دیتابیس توزیع شده و غیررابطه ایه که روی HDFS ساخته شده. HBase برای ذخیره سازی و مدیریت دادههای بزرگ و ساخت نیافته خیلی مناسبه. مثلا فرض کن یه شبکه اجتماعی داری و باید تعداد زیادی پست و کامنت رو ذخیره و مدیریت کنی، HBase بهت کمک میکنه که این کار رو به راحتی انجام بدی و دسترسی سریعی به دادهها داشته باشی.

Apache Phoenix

یه ابزار جالب دیگه Apache Phoenix هست. Phoenix یه موتور پردازش تراکنشهای SQL برای HBase هست. این یعنی اگه دوست داری با دادههای HBase خودت مثل یه دیتابیس رابطه ای کار کنی، Phoenix بهت این امکان رو میده. مثلا میتونی تراکنشهای پیچیده SQL رو روی دادههای خودت اجرا کنی و از قابلیتهای قدرتمند HBase بهره مند بشی.

Apache Spark

شاید تا حالا اسم Apache Spark رو شنیده باشی. اسپارک یه چارچوب پردازش دادههای بزرگه که برای سرعت و کارایی بالا طراحی شده. اسپارک میتونه دادهها رو در حافظه (In-Memory) پردازش کنه، که این باعث میشه خیلی سریعتر از MapReduce عمل کنه. مثلا اگه یه پروژه تحلیل دادههای لحظه ای داری، اسپارک بهت کمک میکنه که این کار رو به سرعت انجام بدی.

Apache ZooKeeper

Apache ZooKeeper یه سرویس هماهنگ سازی برای اپلیکیشنهای توزیع شده ست. ZooKeeper برای مدیریت کانفیگ ها، نام گذاری و هماهنگی بین نودهای مختلف در یه خوشه هدوپ استفاده میشه. این ابزار بهت کمک میکنه که سیستمهای توزیع شده خودت رو به صورت پایدار و قابل اعتماد مدیریت کنی.

Apache Impala

اگه به دنبال یه ابزار برای جستجوی تعاملی روی دادههای بزرگ هستی، Apache Impala عالیه. Impala یه موتور جستجوی تعاملیه که میتونه روی دادههای ذخیره شده در HDFS و HBase کار کنه. با استفاده از Impala میتونی کوئریهای سریع و پیچیده ای روی دادههای خودت اجرا کنی و نتایج رو به سرعت دریافت کنی.

Apache Flume

Apache Flume یه ابزار برای جمع آوری، تجمیع و انتقال دادههای جریانی به هدوپه. Flume به خصوص برای جمع آوری دادههای لاگ از سرورهای مختلف و انتقال اونها به HDFS خیلی مفیده. مثلا اگه دادههای لاگ زیادی داری که باید تحلیل بشن، Flume بهت کمک میکنه که این دادهها رو به صورت بلادرنگ جمع آوری و انتقال بدی.

Apache Sqoop

اگه نیاز داری دادهها رو بین سیستمهای مدیریت پایگاه داده رابطه ای (مثل MySQL یا PostgreSQL) و هدوپ جابه جا کنی، Apache Sqoop بهت کمک میکنه. با Sqoop میتونی دادهها رو از دیتابیسهای مختلف به HDFS انتقال بدی و برعکس. این ابزار بهت اجازه میده که فرآیند انتقال دادهها رو به صورت خودکار و کارآمد انجام بدی.

Apache Oozie

برای مدیریت و زمان بندی کارها در هدوپ، Apache Oozie عالیه. Oozie بهت اجازه میده که جریانهای کاری (Workflows) پیچیده ای رو که شامل کارهای مختلف هدوپ مثل MapReduce، Hive و Pig هستن، تعریف و زمان بندی کنی. این ابزار بهت کمک میکنه تا فرآیندهای پردازش دادهها رو به صورت خودکار و هماهنگ انجام بدی.

Apache Storm

در نهایت، Apache Storm یه سیستم پردازش بلادرنگ برای دادههای جریانیه. Storm بهت اجازه میده که دادههای جریانی رو به صورت بلادرنگ پردازش کنی و تحلیلهای پیچیده ای انجام بدی. مثلا اگه نیاز داری که دادههای لحظه ای از حسگرها یا سیستمهای مختلف رو پردازش کنی، Storm یه ابزار خیلی خوبه.

مثالهای کدنویسی با Hadoop

برای اینکه بهتر بفهمیم چطور میتونیم با Hadoop کار کنیم، بیایید چند مثال ساده رو بررسی کنیم.

مثال ۱: کد MapReduce

در این مثال، یک برنامه ساده Word Count رو با استفاده از MapReduce پیاده سازی میکنیم. این برنامه تعداد تکرار هر کلمه در یک متن رو محاسبه میکنه.

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String w : words) {

word.set(w);

context.write(word, one);

}

}

}

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

job.setJarByClass(WordCount.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}در این کد، ابتدا Mapper تعریف شده که وظیفه ش تقسیم متن به کلمات و اختصاص مقدار ۱ به هر کلمه است. سپس Reducer تعریف شده که وظیفه ش جمع کردن مقادیر و محاسبه تعداد تکرار هر کلمه است. در نهایت، کلاس اصلی برنامه تنظیمات شغل MapReduce رو انجام میده و شغل رو اجرا میکنه.

مثال ۲: ذخیره سازی در HDFS

در این مثال، نحوه ایجاد یک دایرکتوری در HDFS و کپی کردن یک فایل محلی به HDFS رو نشون میدیم.

# Create a directory in HDFS

hadoop fs -mkdir /user/7learn/data

# Copy a local file to HDFS

hadoop fs -put /path/to/local/file.txt /user/7learn/dataدر اینجا، با استفاده از دستور mkdir یک دایرکتوری در HDFS ایجاد میکنیم و سپس با دستور put یک فایل محلی رو به این دایرکتوری کپی میکنیم.

مثال ۳: اجرای یک Job MapReduce

در این مثال، نحوه اجرای شغل Word Count که در مثال اول تعریف شد رو نشون میدیم.

# Run the WordCount job

hadoop jar wordcount.jar WordCount /user/7learn/input /user/7learn/outputدر اینجا، با استفاده از دستور hadoop jar شغل MapReduce رو اجرا میکنیم. مسیر ورودی دادهها و مسیر خروجی نتایج رو هم مشخص میکنیم.

شرکتهای معروف استفاده کننده از Hadoop

بسیاری از شرکتهای بزرگ و معروف از Hadoop برای مدیریت و تحلیل دادههای خودشون استفاده میکنن. بیایید به چند نمونه نگاه کنیم.

۱. گوگل

گوگل یکی از اولین شرکت هایی بود که نیاز به پردازش حجم عظیمی از دادهها رو داشت. اونا از تکنیکهای مشابه Hadoop برای تحلیل جستجوها و بهبود نتایج جستجو استفاده میکنن. با استفاده از این تکنولوژی، گوگل میتونه میلیونها جستجو رو در عرض چند ثانیه پردازش کنه و نتایج مرتبطتری رو به کاربران نشون بده.

۲. فیس بوک

فیس بوک از Hadoop برای تحلیل دادههای کاربران و بهبود تجربه کاربری استفاده میکنه. اونا با تحلیل پست ها، لایکها و کامنتهای کاربران، میتونن الگوهای رفتاری کاربران رو شناسایی کنن و محتواهای مرتبطتری رو بهشون نشون بدن. برای مثال، فیس بوک میتونه تبلیغات هدفمندتری رو به کاربران نشون بده و تجربه کاربری بهتری رو فراهم کنه.

۳. آمازون

آمازون از Hadoop برای مدیریت و تحلیل دادههای خرید و فروش استفاده میکنه. اونا با استفاده از این تکنولوژی، میتونن دادههای مربوط به تراکنش ها، محصولات و مشتریان رو به صورت توزیع شده ذخیره کنن و از این دادهها برای تحلیل بازار و بهبود خدمات خود بهره ببرن. این کار به آمازون کمک میکنه تا محصولات مرتبطتری رو به مشتریان پیشنهاد بده و تجربه خرید بهتری رو برای اونا فراهم کنه.

۴. نتفلیکس

نتفلیکس هم یکی دیگه از شرکتهای بزرگیه که از Hadoop استفاده میکنه. اونا از این تکنولوژی برای تحلیل دادههای مشاهده کاربران و پیشنهاد فیلمها و سریالهای جدید استفاده میکنن. با تحلیل رفتار مشاهده کاربران، نتفلیکس میتونه فیلمها و سریالهای مرتبطتری رو پیشنهاد بده و تجربه کاربری بهتری رو فراهم کنه.

در نهایت، Hadoop با ارائه ابزارهای قدرتمند برای ذخیره سازی و پردازش دادههای بزرگ، به شرکتها امکان میده که از دادههای خودشون به بهترین شکل ممکن استفاده کنن و تصمیمات بهتری بگیرن. این تکنولوژی همچنان در حال پیشرفته و هر روز کاربردهای جدیدتری پیدا میکنه که نشون دهنده اهمیت و تاثیر عمیق اون بر دنیای امروز هست.

سوالات متداول

1. Hadoop چیست؟

بگذارید ساده بگم Hadoop چیه. تصور کنید که یک انباری بزرگ پر از اطلاعات دارید و باید این اطلاعات رو مرتب کنید و هر وقت نیاز داشتید، به راحتی این اطلاعات رو پیدا کنید. Hadoop یک چارچوب نرم افزاری اپن سورس برای ذخیره سازی و پردازش دادههای بزرگه که دقیقاً همین کار رو برای دادهها انجام میده. یعنی، Hadoop به شما کمک میکنه تا دادههای بزرگ رو به راحتی ذخیره کنید، پردازش کنید و هر وقت نیاز داشتید، بهشون دسترسی پیدا کنید.

2. HDFS چیست؟

HDFS، یا همان "Hadoop Distributed File System"، مثل یک سیستم فایل بزرگ و توزیع شده است. فرض کنید که یک کتابخونه بزرگ دارید و هر کتاب به تکههای کوچکتر تقسیم شده و در قفسههای مختلف قرار گرفته. HDFS دقیقاً همین کار رو برای دادهها انجام میده. دادهها رو به تکههای کوچکتر تقسیم میکنه و این تکهها رو در چندین سرور مختلف ذخیره میکنه. اینطوری، حتی اگر یکی از سرورها خراب بشه، دادهها همچنان در دسترس هستن و از سرورهای دیگه بازیابی میشن.

3. MapReduce چیست؟

MapReduce یک مدل برنامه نویسیه که به شما اجازه میده عملیات پردازشی رو روی دادههای بزرگ به صورت موازی انجام بدید. این مدل برنامه نویسی به دو بخش اصلی تقسیم میشه: Map و Reduce. در مرحله Map، دادهها به قطعات کوچکتر تقسیم میشن و هر قطعه به صورت جداگانه پردازش میشه. این پردازشها میتونن به صورت همزمان روی چندین سرور انجام بشن که باعث افزایش سرعت و کارایی میشه. سپس در مرحله Reduce، نتایج به دست اومده از مرحله Map ترکیب میشن تا نتیجه نهایی به دست بیاد.

4. مزایای Hadoop چیست؟

Hadoop مزایای زیادی داره که استفاده از اون رو برای شرکتها جذاب میکنه. یکی از بزرگترین مزایای Hadoop مقیاس پذیری اونه. یعنی شما میتونید با افزایش حجم داده ها، تعداد سرورها رو افزایش بدید و دادهها رو به صورت موازی پردازش کنید. یکی دیگه از مزایای Hadoop هزینه کمشه. چون یک پروژه اپن سورسه، استفاده از اون نیاز به خرید لایسنسهای گران قیمت نداره. انعطاف پذیری هم یکی دیگه از مزایای Hadoop هست، چون میتونه انواع مختلف دادهها رو پردازش کنه. همچنین، HDFS مقاومت بالایی در برابر خرابیهای سخت افزاری داره و دادهها رو به صورت قابل اعتمادی ذخیره میکنه.

5. معایب Hadoop چیست؟

البته، Hadoop معایب خودش رو هم داره. یکی از معایب اصلی Hadoop پیچیدگی اونه. یادگیری و کار با Hadoop نیاز به زمان و تجربه داره. برای کسانی که تازه با این تکنولوژی آشنا شدن، ممکنه کمی دلهره آور باشه. یکی دیگه از معایب Hadoop سرعت پردازش اونه که در برخی موارد کمتر از راه حلهای تجاری دیگه است. برای برخی از وظایف خاص، ممکنه نیاز باشه که از ترکیب Hadoop با سایر تکنولوژیها استفاده کنید تا به بهترین عملکرد دست پیدا کنید.

6. چگونه میتوانم Hadoop را نصب کنم؟

نصب Hadoop چندان پیچیده نیست. شما میتونید Hadoop رو از سایت رسمی Apache دانلود و نصب کنید. راهنمای نصب هم در سایت موجوده که به شما کمک میکنه تا مراحل نصب رو قدم به قدم طی کنید. همچنین، میتونید از منابع آنلاین و ویدئوهای آموزشی استفاده کنید تا با فرآیند نصب بیشتر آشنا بشید.

7. آیا Hadoop اپن سورس است؟

بله، Hadoop یک پروژه اپن سورس است و شما میتونید کد منبع اون رو از مخازن رسمی دریافت کنید. این ویژگی به شما این امکان رو میده که به صورت رایگان از Hadoop استفاده کنید و حتی در صورت نیاز، کدهای اون رو تغییر بدید و بهینه کنید. این مزیت بزرگ به ویژه برای استارتاپها و شرکتهای کوچیک که منابع مالی محدودی دارن، خیلی مهمه.

8. HDFS چگونه کار میکند؟

HDFS دادهها رو به قطعات کوچکتر تقسیم میکنه و هر قطعه رو در چندین سرور ذخیره میکنه. اینطوری، حتی اگر یکی از سرورها خراب بشه، دادهها همچنان در دسترس هستن و میتونید از سرورهای دیگه بازیابی شون کنید. این سیستم فایل توزیع شده باعث میشه که دادهها به صورت قابل اعتمادی ذخیره بشن و شما همیشه به اونها دسترسی داشته باشید.

9. چگونه میتوانم یک Job MapReduce اجرا کنم؟

برای اجرای یک Job MapReduce، ابتدا باید یک فایل jar از کد MapReduce خودتون ایجاد کنید. بعد از اون، میتونید از فرمان hadoop jar برای اجرای این فایل jar استفاده کنید. همچنین باید مسیر ورودی دادهها و مسیر خروجی نتایج رو هم مشخص کنید. این فرآیند به شما کمک میکنه تا عملیات پردازشی خودتون رو به راحتی و به صورت موازی انجام بدید.

جمع بندی

Hadoop یک ابزار قدرتمند برای مدیریت و پردازش دادههای بزرگه که به شرکتها این امکان رو میده که با حجم بزرگی از دادهها کار کنن و تصمیمات بهتری بگیرن. با مزایا و معایب خودش، Hadoop همچنان یکی از مهمترین تکنولوژیهای دنیای داده هاست که در بسیاری از شرکتهای بزرگ جهان استفاده میشه.

امیدوارم این مقاله به شما کمک کرده باشه که با Hadoop و کاربردهای اون بیشتر آشنا بشید و بتونید از این تکنولوژی قدرتمند در پروژههای خودتون استفاده کنید. اگر سوالی دارید یا نیاز به راهنمایی بیشتری دارید، خوشحال میشم کمکتون کنم!

دوره الفبای برنامه نویسی با هدف انتخاب زبان برنامه نویسی مناسب برای شما و پاسخگویی به سوالات متداول در شروع یادگیری موقتا رایگان شد: